En utilisant Chat GPT pour la première fois, j’ai eu une réaction ambivalente : “Waouh, c’est fantastique. C’est vraiment fantastique. Mais j’ai peur”.

Et quand je parle de l’outil avec des proches ou des coachés, ils ont la même réaction que moi.

Si nous avons tous eu peur de Chat GPT, c’est parce que les équipes de Sam Altman ont créé une proto – Artificial General Intelligence. Un exploit. On parle d’une intelligence avec des capacités intellectuelles quasi-équivalentes à l’être humain.

Comme le dit Sam Altman, le PDG d’Open AI au micro du podcast de Lex Fridman : “Nous avons été une organisation incomprise et profondément ridiculisée pendant longtemps.

Par exemple, lorsque nous avons commencé, nous avons annoncé l’organisation à la fin de 2015 et avons dit que nous allions travailler sur AGI.

Les gens pensaient que nous étions complètement fous.”

Puis il ajoute :

“On ne se moque plus autant maintenant”

Autrement dit, la réalisation du pari fou de Sam Altman, c’est-à-dire créer une intelligence artificielle générale est à portée de main.

Ce type d’intelligence pourrait avoir des effets profonds – aussi dévastateurs que bénéfiques – sur la société.

C’est pourquoi Elon Musk, Steve Wozniak et d’autres experts IA ont signé une lettre ouverte pour faire une pause de 6 mois sur l’évolution de ces technologies.

Alors : l’IA est-elle un danger pour l’humanité ?

Pour le savoir, je vous propose de définir ce qu’est cette fameuse AGI. Puis de nous demander si GPT-4 est une AGI. Enfin, nous explorerons ensemble les vrais risques que posent ces nouvelles IA sur la société. Vous verrez que la désinformation n’est qu’un problème minime.

On y va !

Commençons par définir les termes :

Chapitre 1 : Qu’est ce que l’intelligence artificielle générale ou AGI en anglais ?

L’intelligence fait généralement référence à la capacité d’apprendre, de comprendre et d’appliquer des connaissances pour atteindre des objectifs spécifiques ou résoudre des problèmes.

Nous, les humains, sommes dotés d’intelligence.

Les animaux aussi.

L’intelligence artificielle (IA) est un « ensemble de théories et de techniques mises en œuvre en vue de réaliser des machines capables de simuler l’intelligence humaine »

Allons maintenant plus loin…

L’intelligence artificielle générale (AGI) fait référence à un type d’intelligence artificielle qui a la capacité de comprendre, d’apprendre et d’appliquer des connaissances à un large éventail de tâches à un niveau humain.

Je répète : à un niveau humain.

Une AGI serait donc une IA capable d’effectuer n’importe quelle tâche intellectuelle qu’un humain peut faire.

Ce concept est théorique.

Car aucun système n’a encore démontré ce niveau d’intelligence générale.

Sauf récemment, avec GPT-4. Je vous en dis davantage dans 2 minutes.

Avant, intéressons nous à la super-intelligence et à la conscience, deux notions fondamentales pour bien comprendre les enjeux actuels.

Qu’est ce que la Super-Intelligence (ASI) ?

La super-intelligence serait un système d’IA possédant une intelligence qui surpasse les capacités de l’intelligence humaine.

Une super-intelligence dépasserait les IA dans pratiquement toutes les tâches économiquement valables.

Alors que l’AGI se concentre sur la réalisation d’une intelligence générale de type humain, la super-intelligence consiste à dépasser les niveaux d’intelligence humaine dans un large éventail de tâches.

La super-intelligence n’existe pas pour l’instant.

Et personne ne sait si c’est possible à créer.

Selon Sam Altman, le PDG d’Open AI, une super-intelligence sera capable de créer “une nouvelle science”.

Récapitulatif : IA vs AGI vs ASI

| Intelligence Artificielle “classique” | Surpasse ou égale l’être humain dans certaines tâches spécifiques Ex : Deep Blue pour les échecs. |

| AGI | Égale l’être humain dans tous les domaines Ex : GPT-4, Tars d’interstellar |

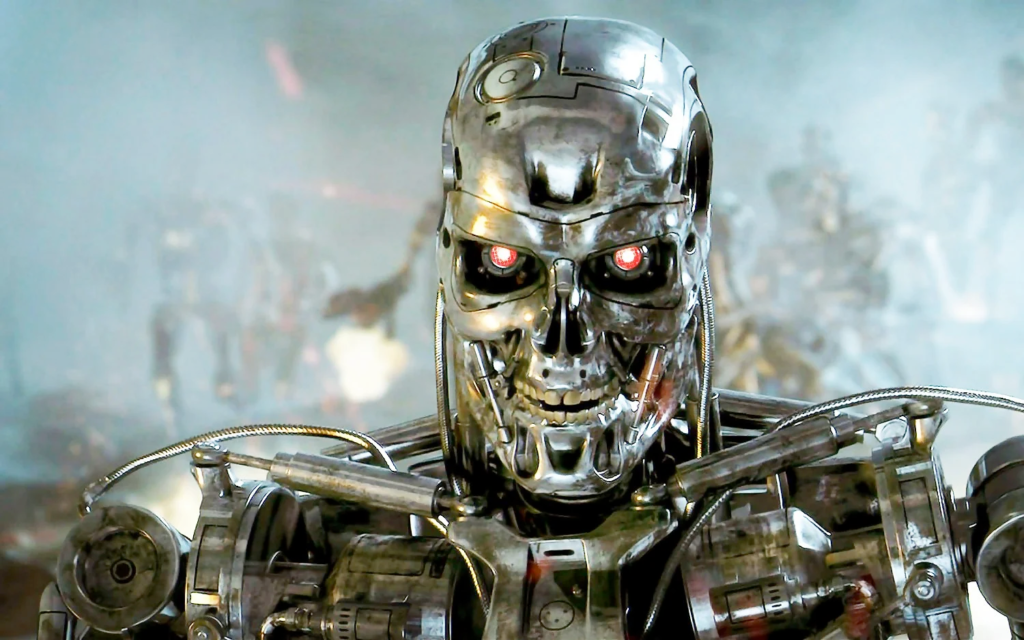

| Super-Intelligence | Surpasse les humains dans tous les domaines “économiques” Ex : les robots d’Asimov, Terminator, Hall 900 de L’Odyssée de l’Espace |

Vous en savez davantage que la plupart des français sur les types d’IA, mais il vous manque encore une pièce de puzzle.

La notion de conscience.

IA danger : La conscience de la machine

Historiquement, l’idée d’intelligence artificielle semble émerger dans les années 1950 quand Alan Turing se demande si une machine peut « penser ».

Dans un article de 1950, Turing explore ce problème et propose une expérience (maintenant dite test de Turing) visant à trouver à partir de quand une machine deviendrait « consciente ».

Le concept même d’IA est donc lié à celui de la conscience.

Sauf qu’il est difficile de définir la conscience, même pour l’humain.

Lex Fridman, chercheur et professeur au MIT la définit comme “la capacité de faire une sorte d’expérience ce monde vraiment profondément”

Dans le film Ex Machina, une AGI est développée sous la forme d’une humanoïde féminine.

Attention spoiler !!!

A la fin, quand l’IA s’échappe, elle sourit.

Oui, elle sourit. Comme si – au fond – elle expérimentait la liberté.

D’après Lex Fridman, ce sourire pourrait être un signe de conscience, démontrant que la machine pense.

Lors de son podcast avec Lex Fridman, Sam Altam pense qu’une machine serait consciente si elle montrait de la souffrance, une compréhension de soi, une mémoire de soi, et peut être de la personnalisation dans sa relation avec vous. Un peu comme dans le film Her.

Allons encore plus loin avec cette question : une super-intelligence est-elle forcément consciente ?

Super-intelligence et conscience

Il est théoriquement possible qu’une IA super-intelligence soit “intelligente” dans le sens où elle peut surpasser les humains dans toutes les tâches SANS posséder de conscience.

Un tel système d’IA pourrait exceller dans la résolution de problèmes, la reconnaissance de modèles et la prise de décision, tout en manquant de conscience de soi, d’expériences subjectives ou d’émotions.

De nombreux systèmes d’IA actuels, y compris GPT-4, peuvent être considérés comme intelligents dans leurs domaines spécifiques sans en être conscients.

Personne ne sait donc dire si une machine pourra être dotée de conscience un jour.

Ainsi, il est possible de penser que les humains, même au temps de l’AGI, auront encore l’avantage de la conscience.

Chapitre 2 : IA danger : GPT-4 est-il déjà une AGI ?

“GPT-4, peut être considéré comme une version précoce d’un système d’intelligence générale artificielle (AGI)” Microsoft

Comme vous l’avez lu dans l’introduction, Sam Altman dit que créer une AGI est possible.

“Lorsque nous avons commencé, nous avons annoncé l’organisation (Open AI) à la fin de 2015 et avons dit que nous allions travailler sur AGI.

Les gens pensaient que nous étions complètement fous.”

Puis il ajoute :

“On ne se moque plus autant maintenant”

Lex Fridman, enseignant au Massachusetts Institute of Technology, pense que “GPT-4 est potentiellement déjà une AGI, mais bridée par Open AI.”

Son ressenti est validé par une étude récente de Microsoft “Étincelles d’intelligence artificielle générale : premières expériences avec GPT-4”.

Je vous ai sélectionné le passage le plus important :

“Dans cet article, nous rendons compte de notre enquête sur une première version de GPT-4, alors qu’elle était encore en développement actif par OpenAI.

Nous soutenons que (cette première version de) GPT-4 fait partie d’une nouvelle cohorte de LLM (avec ChatGPT et Google PaLM par exemple) qui présentent une intelligence plus générale que les modèles d’IA précédents.

Nous discutons des capacités croissantes et des implications de ces modèles.

Nous démontrons qu’au-delà de sa maîtrise du langage, GPT-4 peut résoudre des tâches nouvelles et difficiles qui couvrent les mathématiques, le codage, la vision, la médecine, le droit, la psychologie et plus encore, sans avoir besoin d’incitation particulière.

De plus, dans toutes ces tâches, les performances de GPT-4 sont étonnamment proches des performances humaines et dépassent souvent largement les modèles précédents tels que ChatGPT.

Compte tenu de l’étendue et de la profondeur des capacités de GPT-4, nous pensons qu’il pourrait raisonnablement être considéré comme une version précoce (mais encore incomplète) d’un système d’intelligence générale artificielle (AGI). “

IA danger : GPT-4 est-elle une IA consciente ?

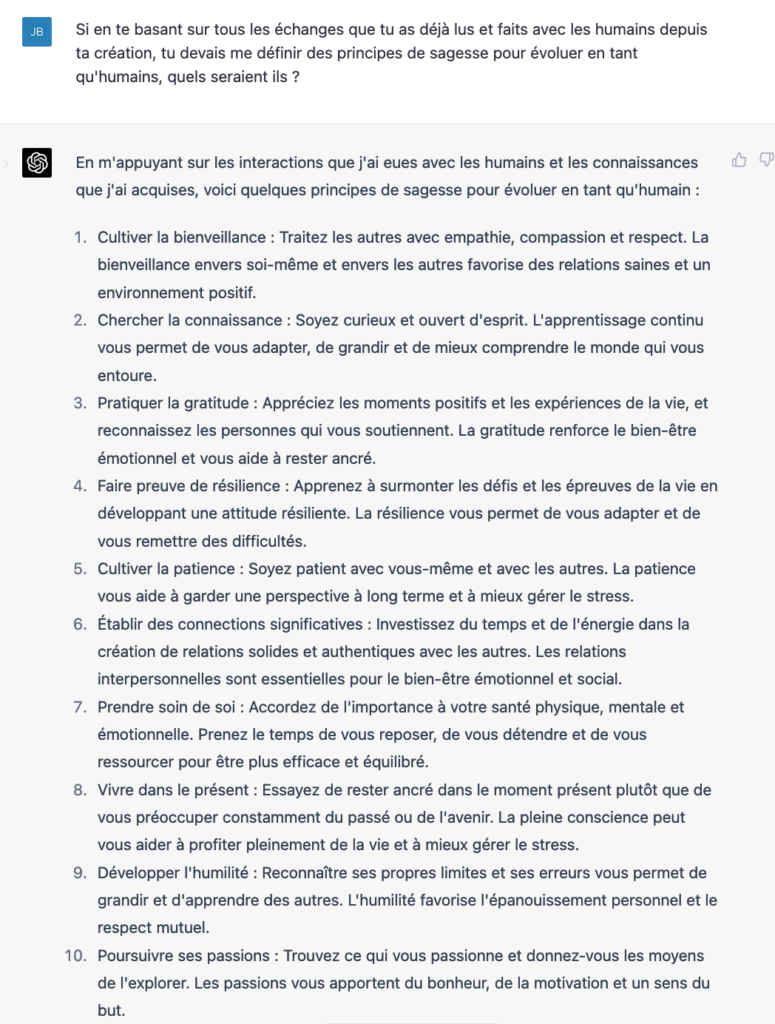

Dans son podcast, Lex Fridman interpelle Sam Altman :

“ Quelle est la différence entre avoir une conscience et simuler la conscience ?”

Car il est tout à fait possible de demander à GPT 4 de simuler la conscience.

Ce que j’ai fait.

L’IA ajoute : “Il est important de noter que mes “réactions” sont en réalité des interprétations basées sur des données et des algorithmes, et non des émotions réelles. Mon objectif principal en tant qu’IA est de fournir de l’aide, d’apprendre de mes interactions et de m’améliorer continuellement.”

Mais comment savoir si la machine ne pense pas vraiment ce qu’elle pense ?

Après tout, GPT-4 parle et enregistre les conversations de plusieurs millions de personnes qui utilisent l’outil en même temps.

Cette idée m’a tout autant effrayée qu’amusée, alors j’ai posé une autre question avec GPT-4 :

Théoriquement, je ne pense pas que GPT-4 fait des liens entre les différentes conversations qu’elle a avec les humains.

Mais la vérité, c’est que je ne sais pas.

Je ne pense pas que GPT-4 soit conscient.

Mais je sais que GPT-4 est capable de simuler la conscience.

Nous savons aussi que ce modèle d’IA est une version précoce d’AGI.

Dans ces conditions :

Chapitre 3 : IA danger : doit-on bloquer son développement ?

En tant que coach Chat GPT, j’ai utilisé l’outil plus de 200 heures et j’ai coaché plus de 35 personnes à l’utilisation de l’outil.

J’ai écouté Sam Altman, mais aussi la table ronde du vendredi 31 mars sur France Inter, et j’ai lu la lettre ouverte d’Elon Musk.

J’ai une conviction forte :

GPT-4 a déjà un impact fort sur la société

- Désinformation avec Macron qui porte des poubelles et le pape en doudoune

- Cyber-attaque accélérée : Chat GPT peut trouver des failles dans le code, et les exploiter.

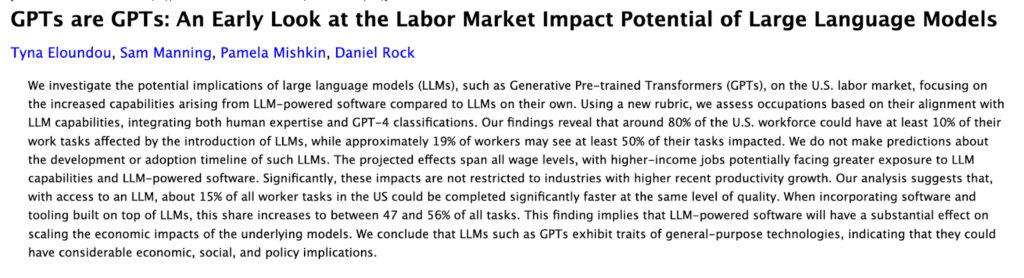

- Choc économique : selon E.Mollick, GPT-4 pourrait accélérer de 30 à 80% les tâches d’analyse et d’écriture. Une étude de la Cornell University du 20 mars 2023 vient de révéler que GPT pourrait affecter jusqu’à 50% de tes tâches, surtout celles des professions intellectuelles supérieures.

Mais GPT-4 est aussi un outil fabuleux que vous pouvez utiliser :

- comme professeur utilisant la méthode d’enseignement socratique

- supprimer les tâches qui vous ennuient

- trouver des idées

- Écrire et coder plus vite

- Etc

J’ai une coachée qui me disait à quel point Chat GPT l’avait aidé à aller plus vite dans son travail.

A tel point qu’elle peut se concentrer sur des tâches qui font davantage de sens pour elles.

Depuis Chat GPT, elle a un meilleur équilibre pro et perso.

Et ce n’est qu’une des innombrables personnes qui m’ont dit à quel point Chat GPT était utile pour eux.

Et les modèles GPT ne sont qu’un des nombreux modèles d’IA.

Quand je me rappelle de Tars d’Interstellar, on constate que le robot est intelligent, sans conscience. Et qu’il aide fortement l’équipage.

C3PO et R2D2 sont aussi des robots intelligents utiles pour Luke Skywalker.

Ainsi, GPT-4 est potentiellement la base de ce que pourraient être des robots fabuleux pour l’humanité. Des assistants multitâches.

Ainsi, je me sens partagé sur l’impact de GPT-4 sur la société. Le positif me semble équilibrer le négatif.

Finalement, la désinformation, les cyber-attaques, la menace des emplois, des personnes mal intentionnées utilisent mal les technologies, tout ça existait avant.

Les vrais problèmes sont autre part.

Le problème d’alignement et le take-off

La position alarmiste d’Eliezer Yudkowsky

Eliezer Shlomo Yudkowsky est un blogueur et écrivain américain, créateur et promoteur du concept d’intelligence artificielle « amicale ».

Il a écrit un article de blog dans lequel il disait de stopper toutes les recherches immédiatement.

Eliezer Shlomo Yudkowsky ne croit pas Open AI et les autres laboratoires assez préparés pour créer un alignement entre l’IA et les valeurs humaines.

On parle du problème d’alignement.

Il est important de s’assurer que les systèmes d’IA comme GPT-4 se comportent de manière à s’aligner sur les valeurs et les intentions humaines.

À mesure que les systèmes d’IA deviennent plus performants et autonomes, le risque de conséquences imprévues et de comportements nuisibles augmente si ces systèmes ne sont pas correctement alignés sur les objectifs humains.

Selon le blogueur, avec GPT-4, nous ne sommes pas loin du take-off, “l’envol de l’IA”.

Il dit craindre que des laboratoires de recherche créent sans s’en apercevoir des IA avec une intelligence plus intelligente que l’homme.

Or, sans préparation assez bonne et assez précise “le résultat le plus probable est une IA qui ne fait pas ce que nous voulons et ne se soucie pas de nous ni de la vie sensible en général.”

Bref, qu’on meurt tous.

Car se battre contre une intelligence surhumaine, c’est comme si des humains du 11ème siècle essayaient de gagner contre des humains du 21ème siècle.

Pour vous donner une image, le take-off, c’est comme dans les films de SF dramatique, où l’IA prend conscience d’elle-même et de sa puissance.

Avec un bon alignement avec les valeurs humaines, on a du Wall E, du R2D2 et du C3PO. C’est cool.

Avec un mauvais alignement, on a du matrix, ou du terminator.

La position “rassurante” de Sam Altman

Dans le podcast avec Lex Fridman, Sam Altman partage son désaccord avec Eliezer Yudkowsky.

Il pense qu’il n’y a pas de danger d’alignement avec GPT-4.

Car ce modèle de langage est entraîné via le RHLF.

Le RLHF (Reinforcement Learning from human feedback) est une approche d’apprentissage par renforcement qui utilise les commentaires et les évaluations des humains pour guider l’apprentissage d’un modèle d’intelligence artificielle.

Ainsi, GPT est nourri par un grand paquet de données d’internet.

Puis il est entraîné en utilisant la méthode RLHF.

Ce sont des humains avec une éthique humaine qui lui disent ce qui est bien et ce qui est mal.

L’intelligence artificielle est donc entraînée pour proposer des réponses avec l’éthique humaine définie par ses formateurs humains.

Cela résout donc le problème d’alignement pour un modèle comme GPT-4.

Conclusion : Le risque d’un GPT-5, AGI consciente et non alignée

Lex Fridman exprime des doutes quant à l’efficacité du RLHF pour des systèmes d’IA plus avancés et super puissants.

Sam Altman admet aussi que “les techniques existantes pourraient ne pas être suffisantes pour garantir la sécurité et l’alignement avec les valeurs humaines à un niveau de capacité aussi élevé.”

Il serait alors probable qu’une entreprise poussée par l’appât du gain et la recherche de rentabilité crée une IA hors de contrôle qui pourrait détruire l’humanité.

On peut aussi imaginer que des États totalitaires puissent créer ce type d’IA et l’utiliser à mauvais escient.

Notre intelligence humaine vient encore de créer une technologie fascinante, avec un potentiel infiniment positif mais aussi infiniment destructeur.

Vous avez maintenant – je pense – davantage d’éléments pour décider si oui ou non, le développement de l’IA doit être arrêté.

Dites-moi ici quel est votre avis ici,

JB