Bonjour,

L’impact environnemental de Chat GPT est une vraie préoccupation et peu de personnes en parlent.

Par exemple, Sasha Luccioni, chercheuse en IA éthique et durable chez Hugging Face a déclaré :

« D’un point de vue fondamental, si vous voulez sauver la planète avec l’IA, vous devez également considérer l’empreinte environnementale de l’IA.

Il n’est pas logique de brûler une forêt et d’utiliser ensuite l’IA pour suivre la déforestation. »

C’est vrai…

Mais comment aborder ce sujet complexe ?

D’un côté, vous avez ceux qui disent : “N’utilisez plus Chat GPT. C’est une bombe environnementale”. Ces derniers nous culpabilisent avec des gros chiffres sur la consommation d’eau alors que les LLMs sont une révolution technologique sans précédent. Nous, Européens, devons apprendre à nous servir, sous peine de déclassement.

De l’autre, il y a les techno-solutionnistes qui disent : “Les LLMs sont la première étape vers l’AGI (Intelligence Artificielle Générale) qui va tous nous sauver. Alors l’impact environnemental est un sujet annexe””.

Dans les lignes qui suivent, je veux me positionner au centre.

Je vous propose une approche pragmatique : “utilisons les LLMs et reconnaissons leur impact environnemental. Puis tentons de diminuer cet impact.”

Mon but est de nous rendre plus réfléchis sur la façon dont nous utilisons ces modèles.

Et voici le programme que je vous propose :

Dans un premier temps, je vais vous partager les éléments de compréhension nécessaires pour appréhender le sujet de l’empreinte environnementale de Chat GPT. Nous découvrirons comment les LLMs sont entraînés, hébergés sur le cloud dans les data centers, ainsi que les matériaux utilisés.

Puis nous étudierons ensemble les chiffres publics partagés concernant la consommation d’eau, énergie, matériaux et CO2.

Nous pourrons alors nous poser cette question : dois-je continuer à utiliser Chat GPT ?

Enfin, je vous dévoilerai les pistes d’atténuation de l’impact de ces LLMs sur la planète.

Allez c’est parti !

Et si vous préférez le format vidéo, voici mon podcast avec Benjamin qui reprend les éléments de l’article :

1 – Fonctionnement et infrastructure des LLMs – Les fondations

Chat GPT est l’agent conversationnel développé par l’entreprise américaine Open AI.

Vous lui posez une question (le prompt) et le chatbot vous répond en prédisant mot à mot la réponse la plus cohérente à votre question.

Pour cela, il utilise un grand modèle de langage (LLM en anglais) comme GPT-3.5, GPT-4 ou dernièrement GPT-4o.

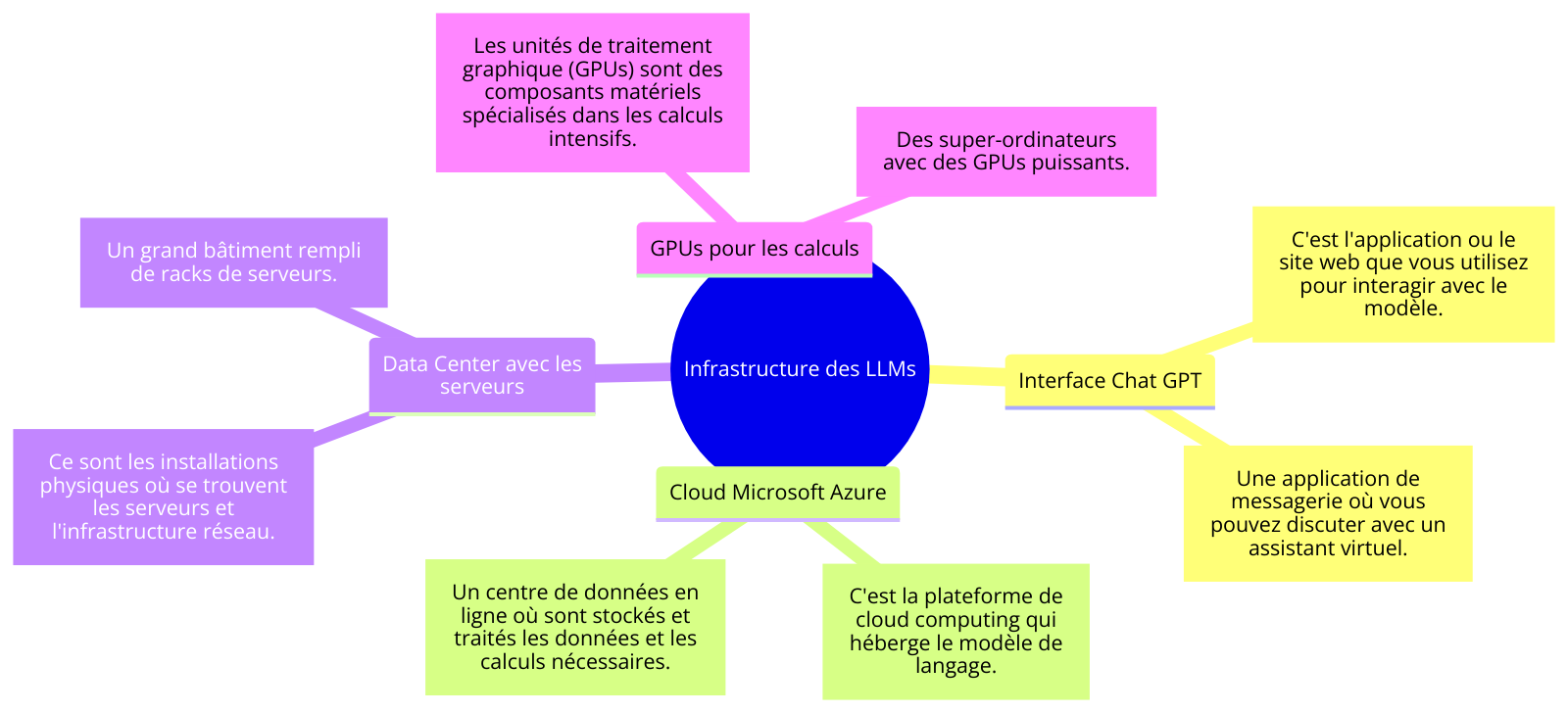

1.1 Résumé visuel : l’infrastructure des LLMs

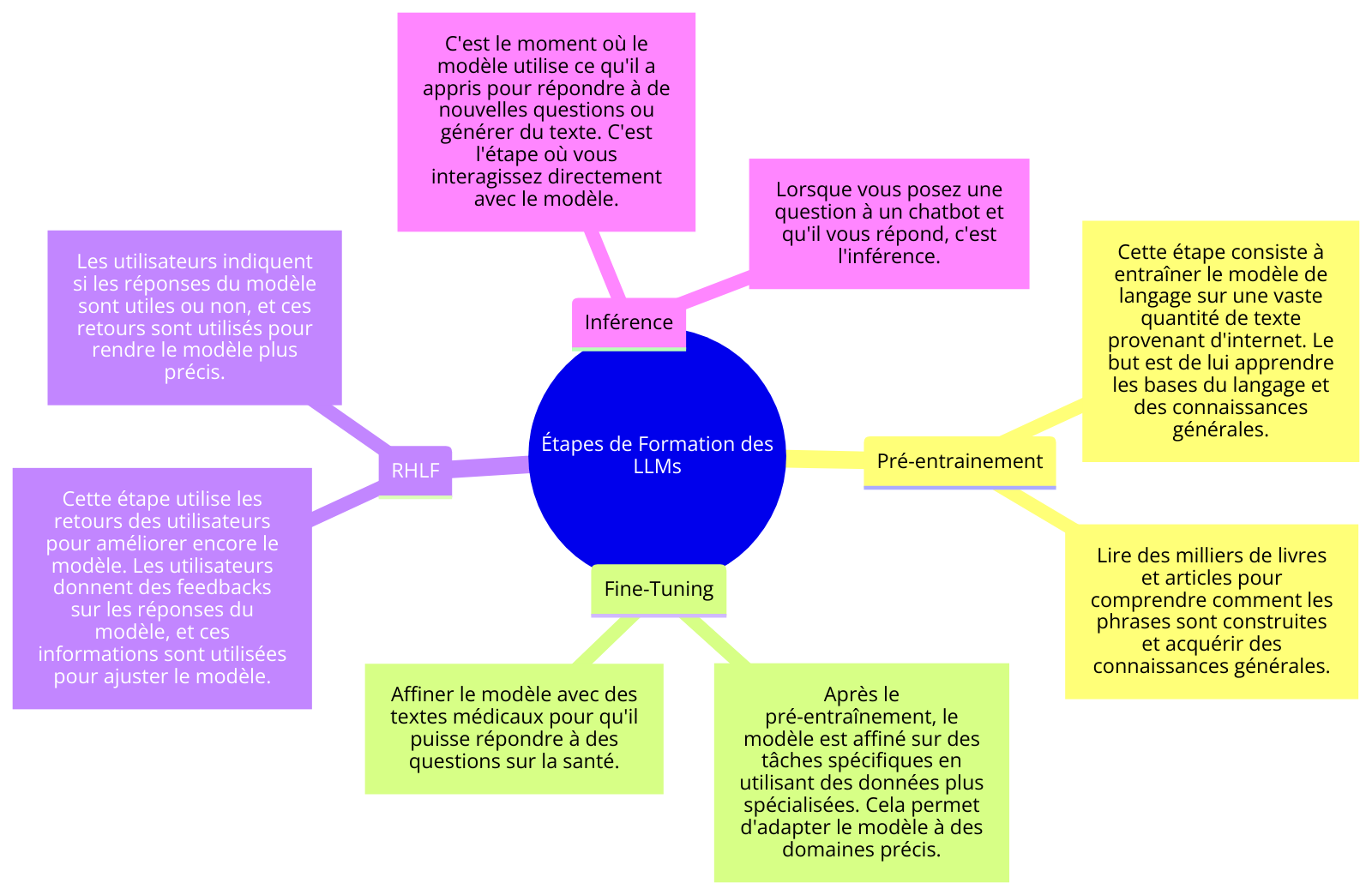

1.2 Résumé visuel : formation des LLMs

1.3 La phase de pré-entraînement des LLMs

Ces grands modèles de langages sont pré-entraînés sur une quantité astronomique de texte. Pensez à l’entraînement comme à un processus de raffinage continu. Le modèle fait des milliers d’essais et d’erreurs, avec des mauvaises prédictions, et il reçoit un retour d’information. Ce feedback lui apprend à faire moins de mauvaises prédictions. Il se rapproche progressivement des bonnes prédictions de réponses.

GPT-3 a 175 milliards de paramètres. Imaginez les paramètres comme des “boutons” ou “ajustements” internes qui aident le modèle à apprendre et à comprendre le langage. Plus il y a de ces ajustements, plus le modèle est capable de comprendre des choses complexes.

Mais il y a un revers de la médaille.

Plus il y a de paramètres, plus le modèle a besoin de puissance de calcul (je simplifie).

Revenons à Chat GPT.

Open AI n’avait pas assez de puissance de calcul pour lancer Chat GPT.

Les fondateurs se sont donc tournés vers Microsoft Azure, le fournisseur cloud exclusif de Microsoft, pour entraîner ses modèles.

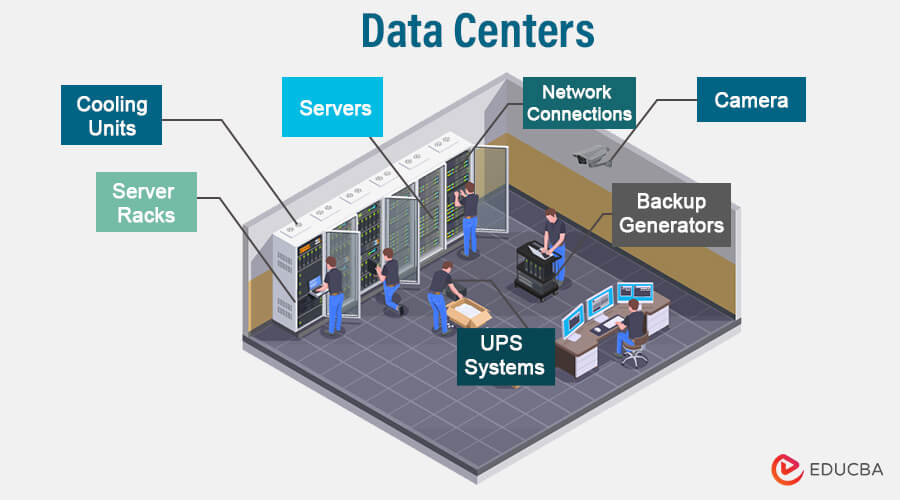

Le cloud fonctionne via des centres de données ou data centers en anglais.

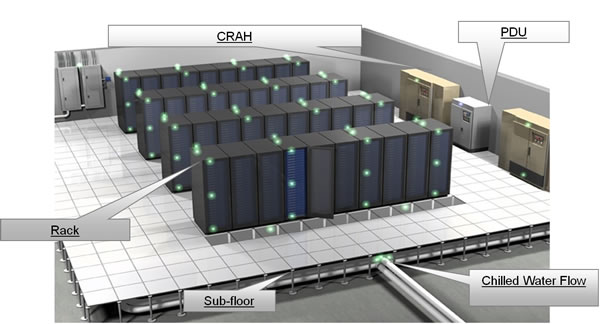

Data Center. Source : EDUCBA.

Et pour entraîner ces grands modèles de langages, il faut des “GPUs”.

Nvidia A100. Source : Nvidia.

Ce sont des processeurs spécialement conçus pour effectuer des calculs très rapidement. Initialement conçus pour le rendu graphique dans les jeux vidéo, les GPU sont très efficaces pour traiter de nombreux calculs en parallèle. Ils sont utilisés pour entraîner et exécuter des modèles d’IA comme ChatGPT parce qu’ils peuvent traiter rapidement de grandes quantités de données.

“En prenant GPT-3 à titre d’exemple, la version 175 milliards de paramètres nécessite 3e23 FLOP (Floating Point Operation) de calcul pour la formation. Si nous utilisons le GPU de pointe le plus disponible, le Nvidia A100, qui peut gérer environ 312 TeraFLOP par seconde (TFLOP), un seul GPU a besoin de 30 ans pour entraîner GPT-3 sans prendre en compte l’utilisation réelle.” Crystal Liu, Tech Investor.

En réalité, Microsoft et Open AI ont mis 34 jours à entraîner GPT-3. Meta a mis 21 jours à entraîner LLama 2. Car vous l’aurez compris, les ingénieurs utilisent plusieurs GPUs ensemble pour entraîner le modèle.

En résumé :

- Chat GPT fonctionne via les modèles de langage, qui ont besoin d’être pré-entraînés sur une grande quantité de données textuelles. Cela demande de la puissance de calcul que Microsoft a fourni via le cloud Azure à Open AI. Azure fonctionne via des centres de données (datacenters) où les GPUs sont particulièrement importants pour faire des calculs rapides. Les grandes sociétés utilisent plusieurs GPUs en même temps pour accélérer le temps d’entraînement.

Pfiou.

Nous avons vu le plus compliqué pour que vous compreniez le sujet d’aujourd’hui.

Mais permettez moi d’aller un cran plus loin.

Découvrez maintenant les autres phases à considérer avant que Chat GPT soit utilisé par vous et moi :

1.4 Fine-tuning, RHLF et inférence : les autres phases d’entraînement des LLMs

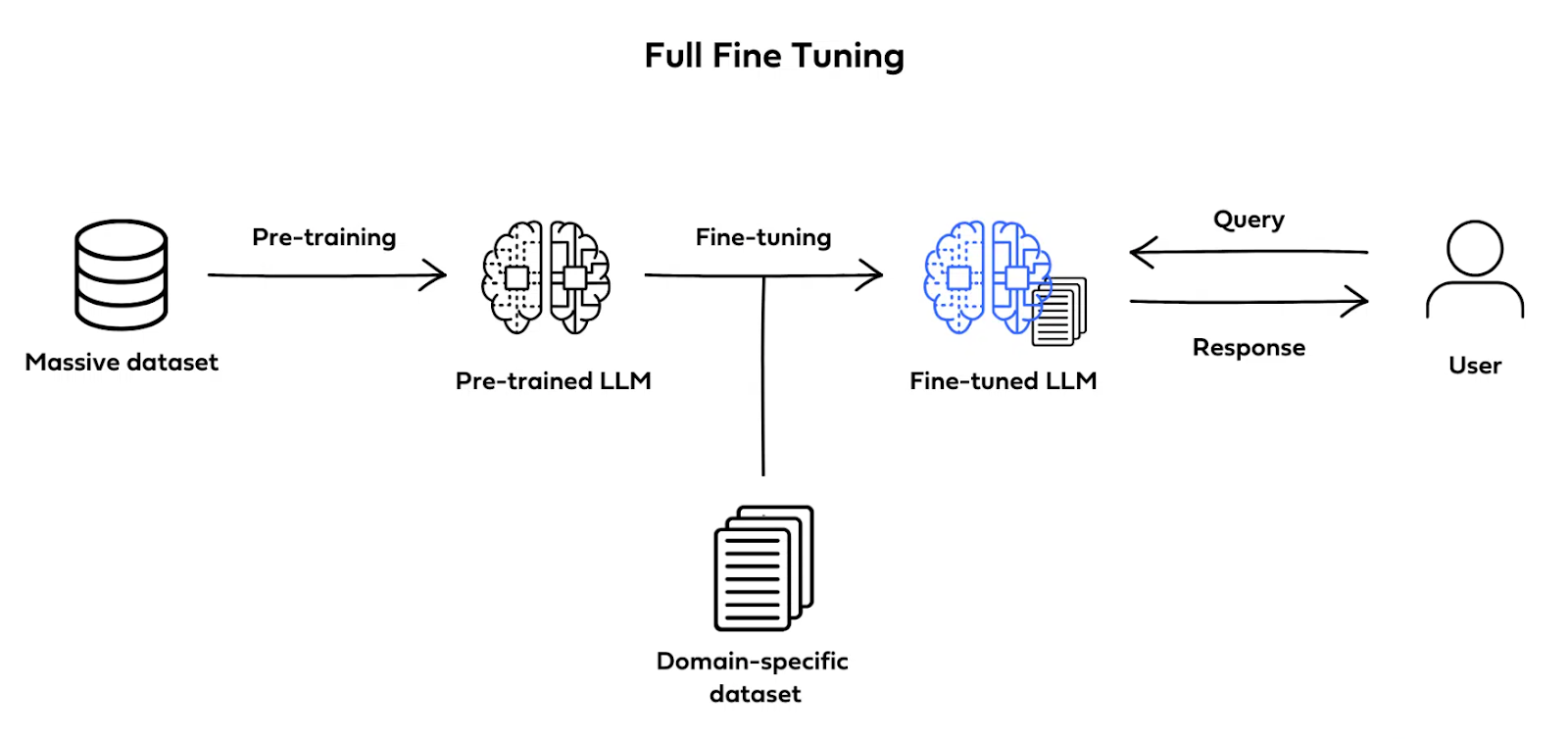

Après le pré-entraînement, les chercheurs continuent avec le fine-tuning.

Le fine-tuning est une sorte de spécialisation du modèle pour qu’il soit doué pour une tâche spécifique. Les ingénieurs utilisent un nouvel ensemble de données spécifique à la tâche (dataset) pour cette étape.

Source : deci.ai

Ensuite vient le Reinforcement Learning from Human Feedback (RLHF) dans le cas de Chat GPT. Open AI a employé des humains pour optimiser les performances de Chat GPT. Ce n’est pas important pour l’impact environnemental (social oui !!). Je ne m’attarde pas dessus.

Enfin, une fois formés, fine-tunés et optimisés, il faut que vous et moi – les utilisateurs finaux – puissions utiliser ces LLMs.

C’est l’inférence.

L’inférence pour les grands modèles de langage, comme GPT-3, est le moment où le modèle utilise ce qu’il a appris pour répondre à de nouvelles questions ou pour produire du texte.

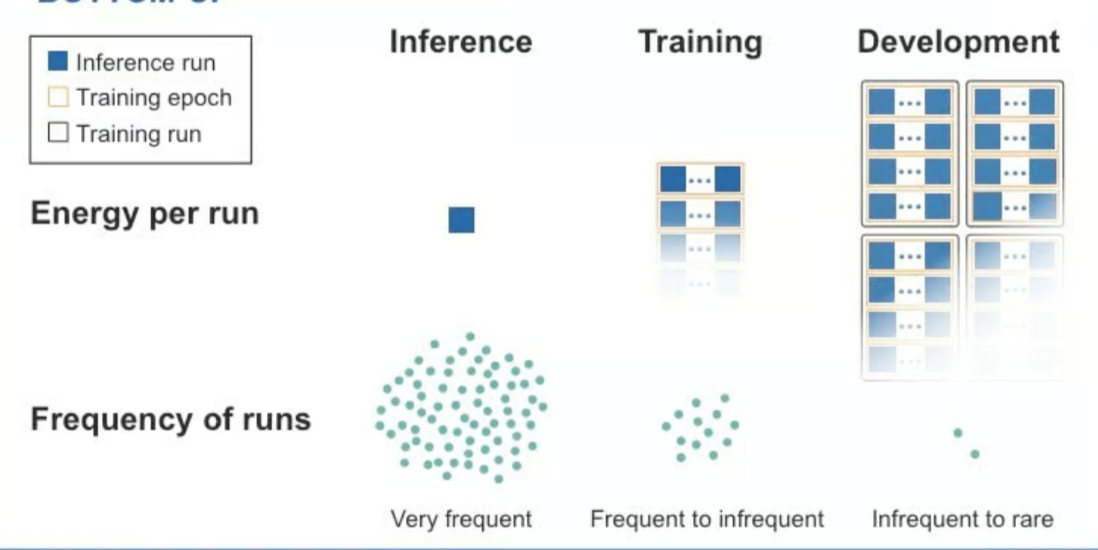

Le pré-entrainement est consommateur de ressources et se fait une fois par modèle.

L’inférence est moins consommatrice mais est plus récurrente.

Chat GPT a 100 millions d’utilisateurs actifs hebdomadaires !!

En résumé, vous avez 4 phases pour que Chat GPT soit utilisé par vous et moi :

- Pré-entraînement

- Fine-Tuning

- RLHF

- Inférence

Maintenant, vous vous posez sans doute cette question :

1.5 Impact environnemental de chat gpt : comment ça marche quand j’envoie une question à Chat GPT ?

ChatGPT : Bonjour ! Lorsque vous envoyez une question, voici ce qui se passe :

- Votre question : Vous tapez une question sur votre appareil (ordinateur, smartphone, etc.) et appuyez sur “Envoyer”.

- Transmission au serveur : Votre question est envoyée via internet à un serveur cloud d’Azure. Pensez à cela comme envoyer une lettre par la poste, sauf que c’est instantané.

- Traitement par ChatGPT : Le serveur reçoit votre question et la transmet au modèle ChatGPT. Le modèle, qui est préalablement entraîné et hébergé sur les serveurs d’Azure, traite la requête en utilisant des GPU pour effectuer les calculs nécessaires. Il trouve la meilleure réponse possible, puis envoie cette réponse au serveur. Imaginez ChatGPT comme un gros cerveau électronique qui réfléchit très vite.

- Réponse retournée : Le serveur envoie la réponse de ChatGPT de retour à votre appareil via le réseau, où vous pouvez la lire immédiatement.

Vous : C’est impressionnant ! Mais où vont mes questions après cela ?

ChatGPT : Bonne question ! Vos conversations sont également traitées de manière sécurisée :

- Collecte des données : Pendant que vous discutez, vos questions et mes réponses sont collectées.

- Transmission et traitement : Ces données sont envoyées aux serveurs d’Azure pour être traitées. Pensez à cela comme un enregistrement de votre conversation.

- Stockage sécurisé : Vos conversations sont stockées dans des bases de données sécurisées sur Azure. Ces données sont chiffrées, ce qui signifie qu’elles sont codées pour les protéger.

- Accès à l’historique : Si vous souhaitez revoir vos conversations, elles sont accessibles via l’interface utilisateur, grâce aux données stockées sur Azure.

En plus du pré-entraînement et de l’inférence, le stockage de vos données consomment aussi des ressources.

2 – L’impact environnemental des grands modèles de langage comme Chat GPT

Vous comprenez désormais :

- comment Chat GPT a été entraîné

- quelle est l’infrastructure sous-jacente avec les data centers et les GPUs

- comment Chat GPT répond quand vous lui posez une question

Nous pouvons donc étudier les impacts.

Je vais en détailler 4 types :

- La consommation d’électricité par les centres de données lors de l’entraînement et l’utilisation (inférence)

- Le rejet de CO2. En fonction de l’énergie utilisée pour alimenter les centres de données, plus ou moins de CO2 est relâché. Cela dépend du mix énergétique du pays.

- La consommation en eau de Chat GPT. Pour le refroidissement des centres de données, les ingénieurs utilisent de l’eau. Le calcul fait chauffer, comme votre PC après 1 ou 2h d’opération intensive pour le processeur. La surchauffe peut causer des dommages matériels, des baisses de performance et bien davantage.

- Les matériaux. Par exemple, les GPUs de NVIDIA sont fabriquées à partir d’aluminium, de CCL(Copper Clad Laminate), de fibres de verre, de gel de silice thermique, d’étain, de tantale et de tungstène. Qui dit matériaux, dit extractions de ressources avec un besoin d’énergie, et émissions de CO2. Et aussi, potentiellement des destructions d’habitats naturels.

Mais avant un récapitulatif et un peu de contexte :

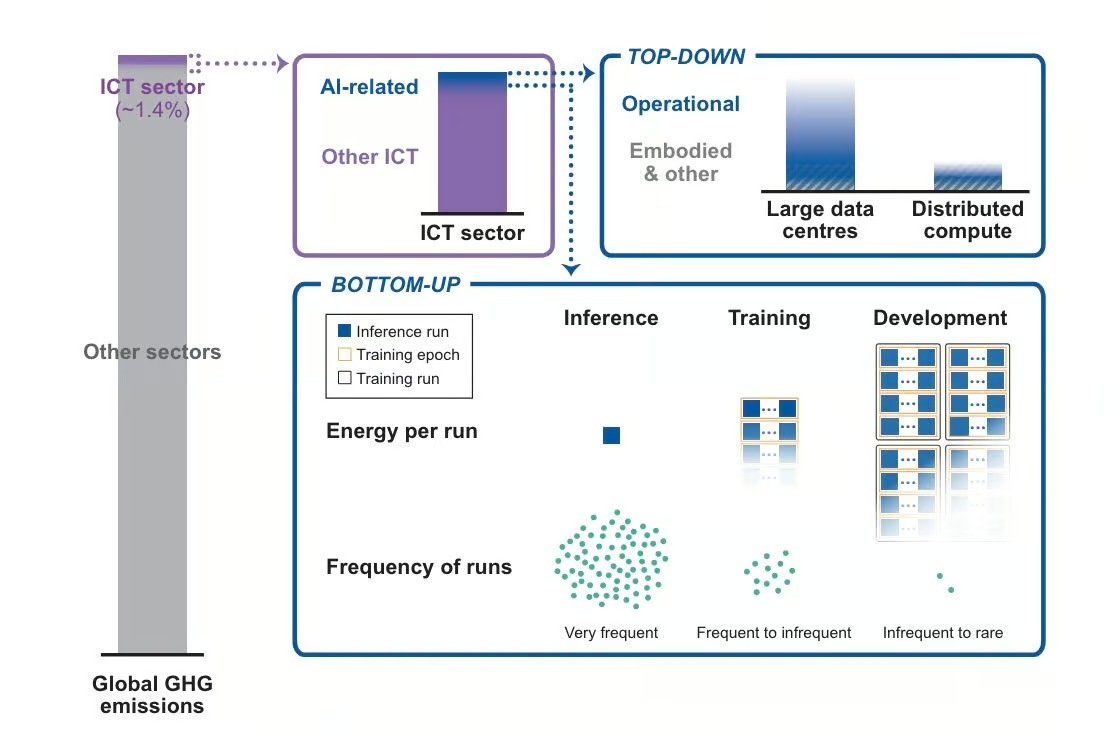

2.1 Quel est l’impact global de l’IA sur la planète ? L’exemple des gaz à effet de serre.

Comme la plupart des technologies, l’IA rejette des gaz à effets de serre comme le CO2.

Selon les études, les technologies d’information et de communication (TIC) contribuent entre 2 et 6% des émissions de gaz à effet de serre.

Une étude de 2023 estime que le secteur participe à hauteur de 1,4% des émissions.

Le sujet fait débat…

Dans ce paysage, les centres de données participent aujourd’hui à 0,1% aux émissions globales à effet de serre, selon un article de Nature.

Et l’IA représente environ 25% de ces émissions des data centers.

Si on prend le schéma ci-dessous :

- Le technologies de l’information représente 1,4% des émissions de GES

- Parmi ces 1,4%, 25% environ seraient liés aux technologies d’IA.

- Dans ces technologies d’IA, il n’y pas que Chat GPT.

Source : Kaack 2022

2.2 Impact environnemental de Chat GPT : quelle est la consommation d’électricité de Chat GPT ?

Les ingénieurs ont utilisé de l’électricité pour pré-entraîner Chat GPT. Ils en utilisent aussi pour l’inférence. Rappelez-vous à chaque fois que vous faites une requête, celle-ci est envoyée à un serveur avec un GPU qui fait des calculs pour vous donner des réponses.

Tous ces processus se passent dans les centres de données microsoft azure.

Dans le centre de données, vous avez :

- les racks, des structures métalliques verticales où sont montés les serveurs et autres équipements informatiques. Un rack peut contenir plusieurs serveurs, unités de stockage, et autres appareils de réseau. Dedans, il y a des boîtes de Calcul NVIDIA, chacune contenant plusieurs GPU.

- Les CRAH, des unités de traitement de l’air utilisées pour refroidir les centres de données. Ils aspirent l’air chaud créé par les équipements informatiques, puis en ressorte un air refroidi.

- Les PDU (Power Distribution Unit) des unités de distribution de l’électricité qui alimentent les racks et les équipements informatiques.

- Sub-floor (Sous-sol), espace utilisé pour la gestion des câbles (électriques, réseau, etc.) et pour la circulation de l’air de refroidissement.

- Chilled Water Flow (Flux d’eau réfrigérée) : le système de refroidissement par eau des centre de données. L’eau réfrigérée circule dans des conduites sous le plancher surélevé et est utilisée par les unités de traitement de l’air (CRAH) pour refroidir l’air chaud extrait des racks. Ce système est crucial pour maintenir une température stable et éviter la surchauffe des équipements.

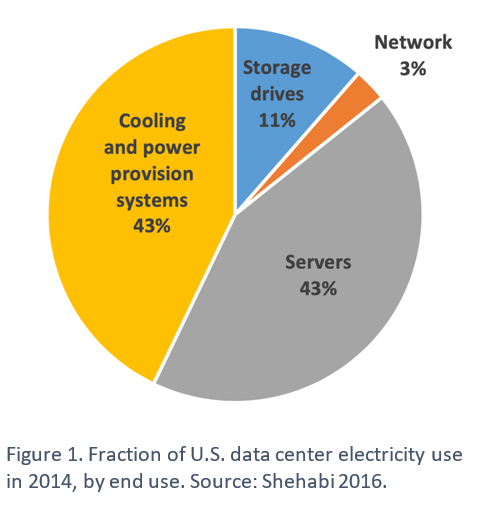

D’après cette étude, ce sont les unités de refroidissement qui utilisent le plus d’électricité avec l’alimentation des serveurs.

- L’Agence internationale de l’énergie (IEA) estime que les centres de données et les réseaux de transmission de données représentent respectivement 1 à 1,5 % de la consommation mondiale d’électricité.

- Les centres de données de l’UE ont consommé environ 45 à 65 TWh d’électricité en 2022 (1,8 à 2,6 % de la consommation totale d’électricité de l’UE). Par exemple, les centrales nucléaires françaises ont produit 335 TWh en 2020.

- L’IEA a également déclaré récemment que la consommation mondiale d’électricité provenant des centres de données, des crypto-monnaies et de l’IA pourrait doubler entre 2022 et 2026. Cela est dû en partie à la demande croissance de serveur boosté à des GPUs gourmands en énergie.

En résumé, l’intérêt croissance des consommateurs pour les solutions type Chat GPT demande des serveurs avec des GPUs, gourmands en énergie.

2.3 Empreinte environnementale de Chat GPT : Quelle est la consommation d’eau de Chat GPT ?

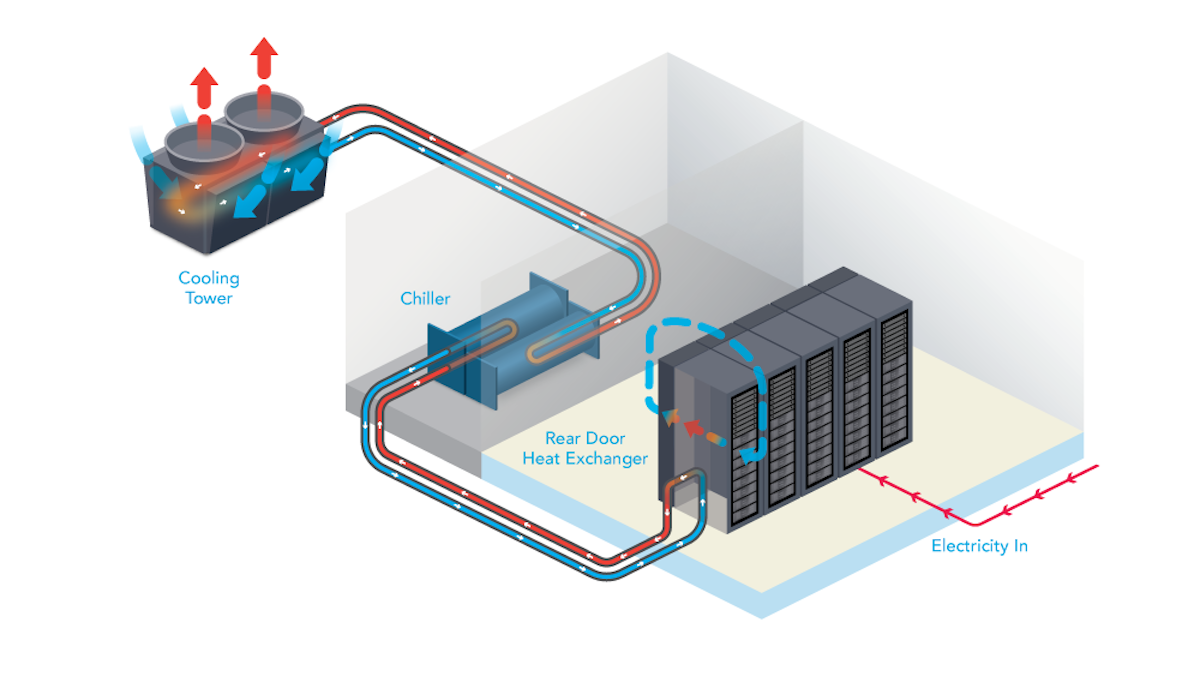

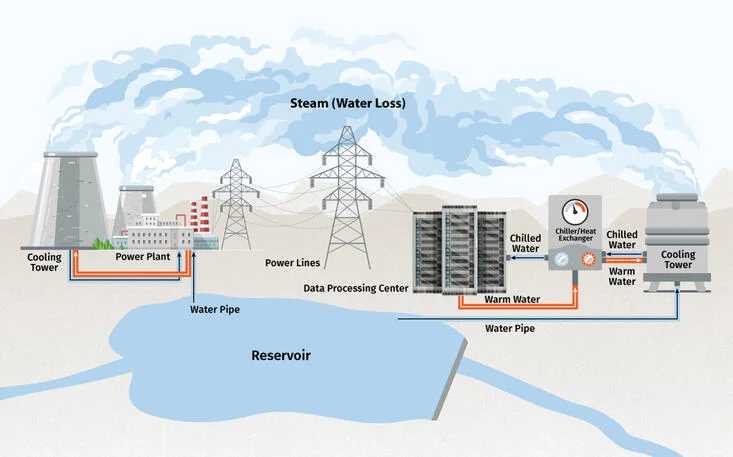

De manière simple, Chat GPT utilise les serveurs avec les GPUs lors de la phase de pré-entraînement et d’inférence. Cette utilisation intensive réchauffe le centre de données. Or pour conserver une bonne performance, la température ne doit pas dépasser 32 degrés celsius. Donc comme nous l’avons vu, les centres de données ont des systèmes de refroidissement. Ces systèmes de refroidissement à base d’eau impliquent la circulation d’eau réfrigérée pour absorber et dissiper la chaleur. Ce processus nécessite souvent de gros volumes d’eau fraîche.

« Malgré les progrès récents dans les solutions de refroidissement, les tours de refroidissement sont principalement la solution de refroidissement la plus courante pour les centres de données à l’échelle des entrepôts, même pour certaines entreprises de premier plan telles que Google et Microsoft, et consomment énormément d’eau », partage Shaolei Ren.

Ainsi, quand on dit que Chat GPT “boit” de l’eau, les chercheurs parlent de cette eau qui s’évapore dans les tours de refroidissement.

Les chiffres de l’étude de l’Université de Riverside

- Phase d’entraînement : on estime que la formation GPT-3 à elle seule a consommé environ 700 000 litres d’eau.

- Phase d’inférence : on estime qu’une simple conversation avec ChatGPT, composée de 20 à 50 questions, peut utiliser environ 500 millilitres d’eau.

Cette étude n’a pas comptabilisé la consommation indirecte d’eau correspondante au refroidissement des centrales de production d’électricité.

« D’une manière générale, nous n’en sommes pas encore au point où l’IA nous enlève de manière tangible l’une de nos ressources naturelles les plus essentielles », dit le co-auteur de l’étude.

Mais sur le long terme, ça en posera.

Par exemple, ça a déjà posé un problème en Uruguay. Où le pays s’est opposé à la création d’un centre de données de Google, car trop consommateur d’eau potable.

2.4 Quelle est l’empreinte carbone de Chat GPT?

Rappelons 3 éléments :

- Open AI utilise l’infrastructure cloud Microsoft Azure

- Selon Nvidia, ils utilisent des GPU A100 de niveau entreprise

- Lorsqu’il est exécuté en continu pendant 24 heures, l’outil a calculé que chaque GPU émettait 1,44 kg de CO2 par jour.

Bien que le nombre exact soit obscur, les rapports indiquent que ChatGPT devrait fonctionner sur environ 30 000 GPU par jour. Il s’agit d’une hypothèse conservatrice, et le nombre réel de GPU déployés pour faire fonctionner l’outil d’IA générative est probablement plus élevé.

- Si nous supposons qu’au moins 30 000 GPU sont utilisés, cela signifie que 43 200 kg de CO2 sont émis quotidiennement.

- Nous savons que ChatGPT a reçu 10 millions de requêtes par jour au cours de la semaine de lancement en novembre 2022. Ce chiffre est probablement beaucoup plus élevé au moment de la rédaction, mais sans chiffres officiels, j’utiliserai cela comme référence.

- 43 200 kg de CO2/10 millions de requêtes = 4,32 g de CO2 par requête de recherche

Pour l’instant, approfondissons ce que signifie 4,32 g d’émissions de CO2 par requête.

En général, vous et moi ne faisons jamais qu’une seule requête. Nous jouons au “ping-pong” avec l’agent conversationnel.

Donc voici quelques équivalences :

- 15 requêtes = regarder une heure de vidéos

- 16 requêtes = faire bouillir une bouilloire

- 20 à 50 requêtes équivalent à la consommation de 500 ml d’eau (comme vu précédemment)

- 139 requêtes = une machine à laver à 30 degrés puis séchés sur un fil avec pince à linge

- 486 111 requêtes = un vol aller-retour de Paris à New York (selon ce calculateur)

Chat GPT a environ 13 millions de visiteurs uniques par jours. Si chacun fait 10 requêtes, cela fait 130 millions de requêtes par jour. Si chaque personne fait 10 requêtes, ça fait 3,9 milliards de requêtes par mois

Cependant, l’empreinte carbone des opérations d’IA varie en fonction du mix énergétique du réseau électrique local.

Par exemple, les opérations d’IA dans les régions disposant de sources d’énergie décarbonée (comme la France) auront une empreinte carbone plus faible que les régions fortement dépendantes des combustibles fossiles.

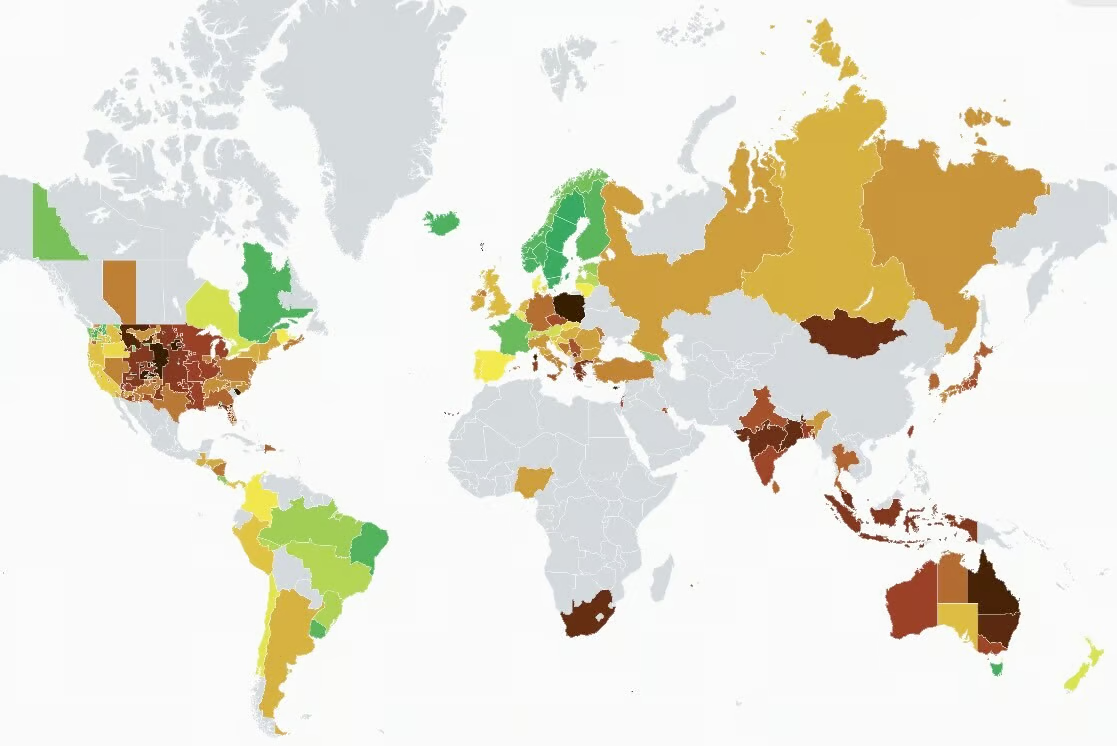

Regardez par exemple cette carte :

Source : Electricitymap. “On est vert grâce au nucléaire.” qui est décarboné mais rappelons pas sans impact autre (cf.déchets)

2.5 Quels sont les matériaux utilisés par Chat GPT ?

Ici, la complexité de calcul augmente encore.

Voyez tous les matériaux utilisés dans un centre de données :

Beaucoup de matériaux différents.

Maintenant, si nous nous focalisons sur les GPUs.

Des analystes se sont concentrés sur le cycle de vie d’un GPU Nvidia en se basant sur le rapport environnemental 2021.

En résumé, les GPUs sont fabriqués à partir de matériaux dont l’extraction est liée à des problèmes éthiques et environnementaux. Par exemple, l’étain, le tantale et le tungstène sont des “minerais de conflit” liés à des violences et des violations des droits de l’homme.

De plus, le processus de production de ces composants consomme beaucoup d’énergie, souvent non renouvelable, contribuant ainsi aux émissions de gaz à effet de serre. Par exemple, l’électricité non renouvelable utilisée par Nvidia a augmenté de 35 % en 2021, tandis que l’énergie renouvelable a diminué de 33 % à 25 %.

La consommation d’eau et la génération de déchets sont également des préoccupations majeures.

Et ce ne sont que les GPUs.

Il faudrait prendre en compte le cycle de vie de tous les serveurs, racks, systèmes de refroidissement liés au fonctionnement de Chat GPT.

Mais il nous manque des chiffres de la part des grandes entreprises.

Au-delà de l’impact environnemental direct, l’extraction de ces matériaux (étain, tantale, tungstène…) soulève aussi des questions géopolitiques et sociales.

Elle est souvent externalisée dans des pays (Congo, Chine, Indonésie…) où les conditions de travail et le respect de l’environnement ne sont pas toujours garantis. Cela pose des problèmes d’exploitation et de néo-colonialisme technologique.

De plus, le développement de l’IA s’inscrit dans une compétition géopolitique entre grandes puissances (USA, Chine, Europe), avec des enjeux de souveraineté et d’indépendance technologique. Vous pouvez écouter ce podcast avec Asma Mhalla sur le sujet.

3 – Comment mitiger les impacts environnementaux des LLMs ?

D’abord, l’idée d’un apprentissage fédéré. En gros, il s’agit de répartir l’entraînement des modèles d’IA sur plusieurs appareils locaux des utilisateurs, plutôt que de tout faire tourner dans des data centers énergivores. Un peu comme si on faisait travailler nos propres machines en réseau, de façon collaborative. Malin.

Ensuite, côté refroidissement des data centers, il y a moyen d’être créatif. Certains acteurs explorent des solutions alternatives comme l’utilisation d’eaux usées, d’eau industrielle ou même d’eau de mer. D’autres misent sur une implantation stratégique dans des zones climatiques plus fraîches. De quoi soulager la consommation d’eau potable.

Tiens, et si la France avait un coup à jouer dans cette partie d’échecs écologique ?

Avec son parc nucléaire conséquent, notre pays dispose d’une électricité bas carbone qui pourrait se révéler un atout pour faire tourner des modèles d’IA gourmands en énergie. Bien sûr, le nucléaire n’est pas non plus exempt de tout impact environnemental, notamment avec la question épineuse des déchets. Mais à court terme, ça pourrait être une option intéressante pour limiter les émissions de gaz à effet de serre.

En parlant de nucléaire, je me demande ce que donnera la piste de la fusion dans les décennies à venir. Si les promesses de cette technologie se concrétisent, on aurait là une sacrée source d’énergie propre et quasiment illimitée. De quoi faire tourner des data centers et entraîner des IA sans trop culpabiliser. Mais bon, ne rêvons pas trop, on n’y est pas encore.

Un autre levier à ne pas négliger : miser sur du matériel plus économe en énergie. Nvidia, avec ses GPU A100, montre la voie. Ces processeurs graphiques sont nettement plus efficaces que des CPU classiques. De son côté, Microsoft met en avant son infrastructure cloud neutre en carbone. Tout cela va dans le bon sens.

Et puis, il y a aussi la question de la recyclabilité des matériaux utilisés dans les infrastructures d’IA. Aujourd’hui, on est encore loin d’un modèle d’économie circulaire. Trop de composants électroniques finissent leur vie dans des décharges à l’autre bout du monde. Il faudrait que les géants de la tech se penchent sérieusement sur le sujet, en concevant des produits plus facilement recyclables et en mettant en place de vraies filières de récupération.

Enfin, il y a tout un champ d’innovation à explorer pour concevoir des puces encore moins gourmandes et optimiser les modèles d’IA afin de réduire leur bilan carbone.

Cela dit, ne soyons pas naïfs. Toutes ces réflexions s’inscrivent dans un système capitaliste qui repose encore largement sur une logique extractiviste. On va chercher toujours plus de ressources dans les entrailles de la terre pour alimenter une croissance sans fin. Les technologies d’IA, aussi prometteuses soient-elles, participent de cette dynamique. Mais que voulez-vous ? Le monde est ainsi fait.

Je ne crois pas qu’il faille diaboliser Chat GPT.

Avec une approche raisonnée et des efforts pour en limiter les excès, les technologies d’IA peuvent aussi être un formidable levier de transformation positive.

Comme souvent, tout est une question d’équilibre et de discernement.

4 – Dois-je continuer à utiliser Chat GPT pour limiter mon impact environnemental ?

Ma réponse est oui, mais de manière réfléchie et parcimonieuse.

Reconnaissons-le, l’empreinte environnementale de ces grands modèles de langage est substantielle. Chaque question que nous posons à Chat GPT a un coût en termes d’électricité, d’eau et de ressources consommées dans les data centers. Même si à notre échelle individuelle cela peut sembler dérisoire, quelques grammes de CO2 par-ci, quelques centilitres d’eau par-là, mis bout à bout avec des millions d’utilisateurs, ça finit par peser lourd dans la balance écologique.

Pour autant, je ne crois pas qu’il faille jeter le bébé avec l’eau du bain. Ces agents conversationnels dopés à l’IA représentent une vraie rupture technologique, avec un potentiel immense pour transformer nos vies, nos métiers, notre société. Productivité boostée, créativité augmentée, connaissances démocratisées… Les promesses sont grandes et bien réelles. Je crois que l’IA générative est un malgré tout un progrès pour l’humanité. Et en tant qu’Européens, nous ne pouvons pas nous permettre de passer à côté de cette révolution.

Alors quelle est la bonne posture à adopter ?

Concrètement, je vois trois leviers à notre portée.

1- D’abord, sollicitons Chat GPT quand c’est vraiment utile et pertinent, évitons les requêtes superflues.

2 – Ensuite, allons droit au but dans nos conversations avec lui, pas besoin de multiplier les échanges juste pour le plaisir.

3- Enfin, poussons les entreprises qui développent ces systèmes à poursuivre leurs nécessaires efforts pour en réduire l’empreinte environnementale.

Bref, profitons des immenses apports de cette technologie, mais avec modération et discernement.

C’est comme cela que nous pourrons faire d’une IA comme Chat GPT un progrès désirable et durable.

Qu’en dites-vous ?

Jean-Baptiste.