Le feuilleton d’Open AI a montré qu’une entreprise bien établie pouvait partir en fumée en quelques jours.

Ces journées tumultueuses m’ont permis de discuter avec des experts du domaine.

Je me suis alors rappelé d’une chose fondamentale : les champions de l’IA aujourd’hui ne seront pas forcément les champions de demain.

Vous rappelez-vous de MySpace ?

Vous rappelez-vous de MSN ?

Vous rappelez-vous des téléphones blackberry, nokia ou sony ericsson ?

Aujourd’hui, ces produits sont morts.

Alors qui sait ?

Peut-être qu’Open AI ne dominera plus le marché dans les 5 à 10 années qui viennent.

Il est donc urgent d’aller explorer des alternatives, qu’elles soient Open Source ou propriétaires.

Dans les minutes qui viennent, je vais d’abord vous présenter un ensemble de définition indispensable pour comprendre les présentations des modèles.

Puis je vous parlerai de votre futur allié indispensable : huggingface.co

Enfin, je vous citerai d’abord les modèles Open Source puis les principaux modèles propriétaires.

Les définitions de l’IA

Modèle de langage : En traitement automatique des langues, un modèle de langage,est un modèle statistique de la distribution de symboles distincts (lettres, phonèmes, mots) dans une langue naturelle. Un modèle de langage vise fondamentalement à prédire le mot suivant dans une séquence de mots

Grand Modèle de Langage (LLMs) : est un modèle de langage possédant un grand nombre de paramètres (généralement de l’ordre du milliard de poids ou plus). Ce sont des réseaux de neurones profonds (sous-domaine de l’IA = deep learning) entraînés sur de grandes quantités de texte non étiqueté utilisant l’apprentissage auto-supervisé (méthode d’apprentissage automatique d’un ordinateur) ou l’apprentissage semi-supervisé. Les LLM sont apparus vers 2018 et ont été utilisés pour la mise en œuvre d’agents conversationnels. Ils sont doués dans un large éventail de tâches commela compréhension et la génération de langage naturel.

Paramètres : Pensez aux paramètres d’un modèle d’intelligence artificielle (IA) comme aux ingrédients d’une recette de cuisine. Dans une recette, vous avez différents ingrédients (comme la farine, le sucre, les œufs) et la quantité de chaque ingrédient affecte le goût du gâteau final. De même, dans un modèle d’IA, les paramètres sont les “ingrédients” qui déterminent comment le modèle va réagir et répondre à différentes sortes de données ou de questions.

Benchmarks : Tests ou ensembles de données utilisés pour évaluer la performance des modèles d’IA.

HuggingFace : Plateforme populaire pour trouver, utiliser et collaborer sur des modèles d’IA.

Fine-tuning : Processus d’ajustement ou de personnalisation d’un modèle d’IA pré-entraîné pour une tâche ou un ensemble de données spécifique.

Dataset : ensemble de données sur lesquelles les IA sont entrainées. Les chercheurs ont par exemple entraîné Chat GPT sur un corpus de données textuelles, dont des articles wikipédia. Mais pas que.

Inference : Le processus par lequel un modèle d’IA applique ce qu’il a appris à de nouvelles données.

La plateforme à connaître : Hugging Face

Hugging Face est une entreprise technologique de pointe spécialisée dans le domaine de l’intelligence artificielle (IA), en particulier dans le traitement du langage naturel (NLP).

Elle est connue pour son approche collaborative et open-source, ce qui en fait une ressource inestimable pour les chercheurs, les développeurs et les passionnés de l’IA.

Concrètement, vous pouvez aller sur Hugging Face et tester de nombreux modèles d’IA Open Source. Vous pouvez les télécharger, les faire fonctionner sur cette plateforme et recevoir de l’aide des autres membres de la communauté.

Comment tester des modèles Open Source sur Hugging Face ?

Nous allons faire un exemple :

Etape 1 : Rendez-vous sur : https://huggingface.co/

Etape 2 : Allez dans l’onglet Space

Etape 3 : Cherchez Mistral (qui est le modèle de langage développé par Mistral AI l’entreprise française d’intelligence artificielle)

Etape 4 : Regardez là où il y a beaucoup de cœur (ça veut dire que c’est beaucoup utilisé) puis entrez dans un space. Par exemple celui ci : https://huggingface.co/spaces/osanseviero/mistral-super-fast

Etape 5 : Chattez gratuitement avec le modèle. Attention, vos informations ne sont pas privées. Donc ne mettez pas votre code de CB 😉

Alternative gratuite, open source et puissante à Chat GPT : Hugging chat

Aussi, Hugging Face a créé un chatbot basé sur des modèles Open Source : https://huggingface.co/chat/

Ce chatbot vous permet de sélectionner un des 4 modèles Open Source les plus puissants (LLama, Mistral, Falcon, Open Chat), puis de chatter avec.

Pour l’instant, l’interface est libre d’accès et gratuite.

Pensez à désactiver l’entraînement des modèles dans Settings.

Maintenant, découvrons les autres modèles Open Source :

A – Les modèles Open Source

Un chercheur en IA disait que les modèles Open Source étaient à 6 mois d’égaler GPT-4.

Certains autres parlent de 2 ans pour qu’Open AI soit rattrapé.

En fait, on ne sait pas.

Car le code de GPT-4 n’a encore jamais été dévoilé.

Ceci étant dit, les modèles suivants ont de bons résultats, souvent équivalent à GPT 3.5.

Voici le premier.

1 – Les modèles Llama de Meta

Llama 2, développé par Meta, représente une avancée majeure dans les modèles d’IA. Ce modèle open source, compatible avec Azure et Windows grâce à un partenariat avec Microsoft, est conçu pour diverses applications avancées. Il se distingue par des données d’entraînement plus étendues et variées que son prédécesseur, Llama 1, offrant une meilleure compréhension et performance.

Llama 2 se démarque par sa disponibilité élargie, optimisée pour des plateformes telles qu’AWS, Azure, et la plateforme d’hébergement de Hugging Face. Il est également intégré dans les systèmes Windows et appareils Qualcomm Snapdragon. Cette version est spécialement conçue pour être plus sécurisée et fiable, réduisant les risques de production de contenus trompeurs ou nocifs.

Les caractéristiques clés de Llama 2 incluent des données d’entraînement diversifiées, une collaboration avec Microsoft, une disponibilité ouverte pour un large public, une conception axée sur la sécurité, et des versions optimisées pour différentes applications, notamment les conversations bidirectionnelles. Llama 2, avec ses 7 à 70 milliards de paramètres, marque une étape significative dans le domaine de l’IA conversationnelle.

Tester LLama 2 sur Hugging Face : https://huggingface.co/chat/ (sélectionnez meta-llama/Llama-2-70b-chat-hf)

2 – MPT de Mosaic ML

MosaicML Foundations a lancé MPT-7B, un LLM (Large Language Model) de style GPT, open-source, axé sur la performance et la stabilité. Ce modèle, entraîné sur un ensemble de données massif de 1 trillion de tokens, s’est démarqué par sa capacité à gérer du texte et du code, complétant sa formation en 9,5 jours sur la plateforme MosaicML.

MPT-7B se positionne comme un outil clé pour les applications commerciales, notamment dans l’analytique prédictive et la prise de décision. Il propose également des versions spécialisées pour des tâches précises, telles que le suivi d’instructions, la génération de dialogues, et la création de récits longs.

Tester MPT 30 B chat sur hugging face : https://huggingface.co/spaces/mosaicml/mpt-30b-chat

3 – Les modèles Falcon de l’Institut de l’Innovation Technologique

Falcon LLM, et en particulier sa version Falcon-40B, est devenu un acteur majeur parmi les LLMs (Large Language Models). Falcon-40B est un modèle doté de 40 milliards de paramètres, entraîné sur un trillion de tokens, et fonctionne selon un modèle autoregressif décodeur-seul, similaire au modèle GPT. Ce qui le distingue est sa performance supérieure à GPT-3, atteinte avec un budget de calcul inférieur de 25 % et moins de calculs requis pour l’inférence.

Le développement de Falcon par l’Institut de l’Innovation Technologique (une organisation financée par le gouvernement d’Abu Dhabi aux Emirats Arabe Unis) a mis l’accent sur la qualité des données de formation, utilisant une pipeline de données étendue pour garantir l’extraction de contenu de haute qualité. Falcon-40B a été formé sur le dataset RefinedWeb, une version améliorée de CommonCrawl, et a été évalué contre plusieurs benchmarks open-source.

En plus de Falcon-40B, d’autres versions ont été introduites, dont Falcon-7B, avec 7 milliards de paramètres, et des modèles spécialisés pour des tâches spécifiques.

Tester Falcon 180B Chat sur Hugging Face : https://huggingface.co/chat/ (sélectionnez falcon-180B-chat)

4 – Les modèles Vicuna de LMSYS Org

Large Model Systems Organization (LMSYS Org) est une organisation de recherche ouverte fondée par des étudiants et des enseignants de l’UC Berkeley, en collaboration avec l’Université de Californie à San Diego (University of California, San Diego) et l’Université Carnegie Mellon (Carnegie Mellon University), une université privée de recherche située à Pittsburgh, en Pennsylvanie.

Large Model Systems Organization (LMSYS Org) a introduit Vicuna-13B, un chatbot open-source formé en utilisant LLaMA et des conversations partagées par les utilisateurs via ShareGPT. Des tests préliminaires montrent que Vicuna-13B atteint presque le niveau de qualité de modèles connus comme ChatGPT d’OpenAI et Google Bard.

Vicuna-13B excelle face à d’autres modèles comme LLaMA et Stanford Alpaca dans la plupart des cas. Son processus de formation a coûté environ 300 $, et son code, ses poids et une démo sont disponibles en ligne pour un usage non commercial.

Le modèle a été affiné avec 70 000 conversations ChatGPT, permettant de générer des réponses détaillées et structurées, comparables à celles de ChatGPT. L’évaluation de Vicuna-13B, notamment à travers des tests basés sur GPT-4, indique qu’il atteint 90 % des capacités de modèles comme Bard/ChatGPT

Tester Vicuna : https://chat.lmsys.org/ puis allez sur Direct Chat et sélectionnez le modèle Vicuna 33B, celui avec le plus de paramètres.

Découvrez la Chatbot Arena

Dans https://chat.lmsys.org/, l’organisation a créé un jeu où vous pouvez tester anonymement un modèle contre un autre.

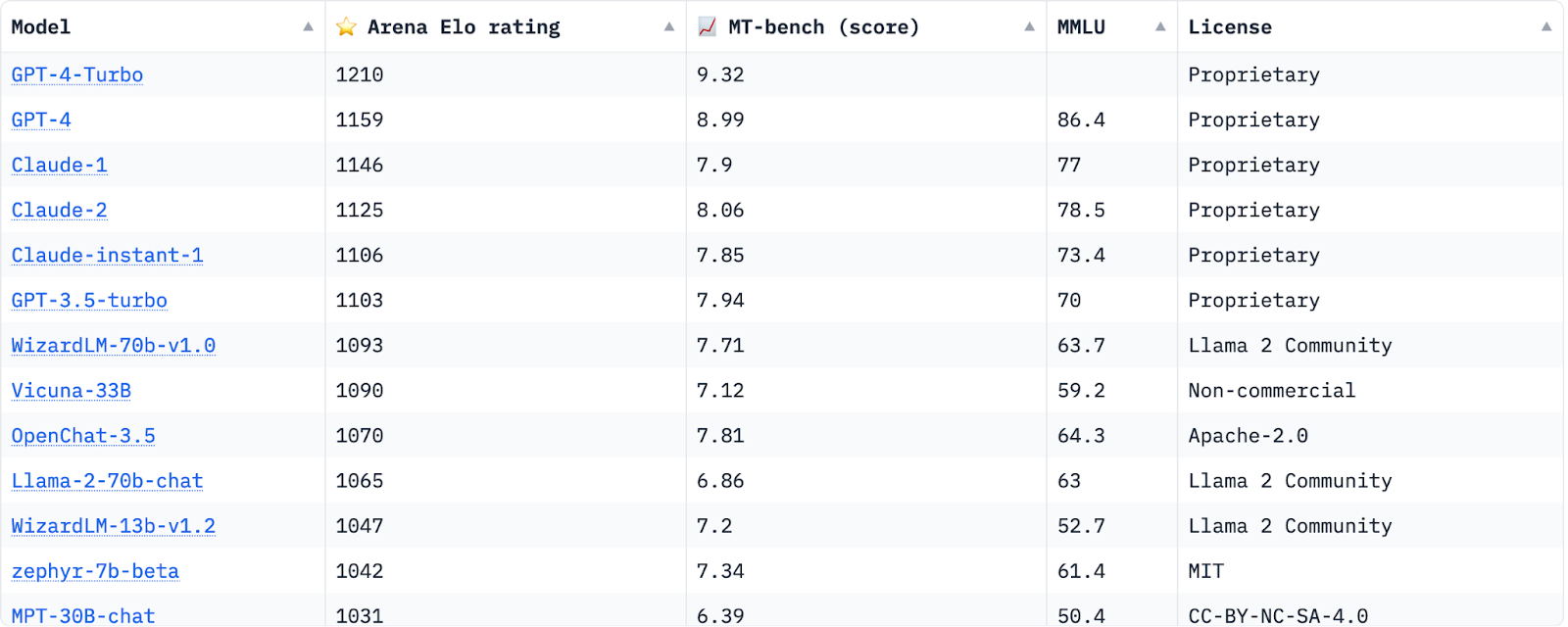

Ensuite, en fonction des plus de 100 000 retours d’utilisateurs, ils ont fait un classement que vous pouvez dans Leaderboard.

Pas de secret. Pour l’instant, GPT-4 Turbo – le dernier modèle d’Open AI – règne en maître

5 – Alpaca 7B

Dernière innovation de Stanford CRFM, Alpaca 7B se distingue dans l’arène des Modèles de Langage à Grande Échelle (LLMs). Affiné à partir du modèle LLaMA 7B de Meta, Alpaca a été formé sur 52 000 démonstrations de suivi d’instructions, rivalisant avec la qualité de text-davinci-003 d’OpenAI.

Ce qui frappe avec Alpaca, c’est sa capacité à livrer des performances de haut niveau tout en restant étonnamment accessible et économique. Coûtant moins de 600 $ à reproduire, il représente une avancée majeure pour la recherche académique, rendant les études sur les LLMs plus abordables.

6 – Mistral 7B

Mistral AI – une entreprise française – a récemment lancé Mistral 7B, un modèle de langage innovant de 7,3 milliards de paramètres. Ce modèle se distingue par ses performances exceptionnelles, surpassant les modèles Llama 2 13B et Llama 1 34B dans de nombreux tests, notamment en programmation et en tâches en anglais.

Accessible sous la licence Apache 2.0, Mistral 7B est libre d’utilisation et compatible avec diverses plateformes cloud comme AWS, GCP, et Azure, en plus d’être disponible sur HuggingFace. Le modèle a été spécialement affiné pour les tâches de chat, montrant des capacités supérieures dans ce domaine par rapport à Llama 2 13B.

Mistral 7B a été rigoureusement évalué face à la famille Llama 2, démontrant une performance nettement supérieure sur une variété de benchmarks. Il offre un avantage significatif en termes de coût et de performance, fournissant des résultats équivalents à un modèle Llama 2 trois fois plus grand, tout en économisant en mémoire et en rapidité de traitement.

Tester Mistral AI 7B sur Hugging Face : https://huggingface.co/chat/ (sélectionnez mistralai/Mistral-7B-Instruct-v0.1)

7 – Open Chat de l’Université Tsinghua

Le projet OpenChat est mené par une équipe d’étudiants de l’Université Tsinghua : Wang Guan et Cheng Sijie.

OpenChat est une bibliothèque innovante de modèles de langage open-source, affinée avec la stratégie C-RLFT, inspirée de l’apprentissage par renforcement hors ligne. Cette approche permet aux modèles d’apprendre à partir de données de qualité mixte sans étiquettes de préférence, offrant ainsi une performance exceptionnelle comparable à celle de ChatGPT, même avec un modèle de 7 milliards de paramètres. L’objectif d’OpenChat est de développer un modèle de langage open-source de grande taille, à la fois performant et viable commercialement.

Testé contre Grok, le modèle propriétaire d’Elon Musk, il a de meilleurs résultats selon certains tests. Ce qui est remarquable pour un modèle avec seulement 7 milliards de paramètres. Selon le leaderboard de LMSYS Org, il a de meilleurs résultats que Llama 70 B.

Tester Open Chat sur Hugging Face : https://huggingface.co/chat/ (sélectionnez mistralai/Mistral-7B-Instruct-v0.1)

8 – Bloom de BigScience

BLOOM est un modèle d’IA avec 176 milliards de paramètres, capable de gérer 46 langues naturelles et 13 langages de programmation. Il a été développé dans le cadre d’une collaboration internationale impliquant plus de 1000 chercheurs de plus de 70 pays. Formé sur le superordinateur Jean Zay près de Paris, BLOOM est conçu pour être un outil multilingue et multidisciplinaire.

Ce modèle se distingue par son accessibilité, étant intégré dans l’écosystème Hugging Face pour une utilisation et un import faciles. BLOOM est donc accessible à un large éventail d’utilisateurs, indépendamment de leurs ressources financières. Ce projet vise à faciliter l’exploration linguistique et la recherche en IA pour une diversité d’utilisateurs à travers le monde

Tester Bloom : https://huggingface.co/spaces/huggingface/bloom_demo

9 – Les autres solutions Open Source

ColossalChat

ColossalChat, basé sur le modèle LLaMa et PyTorch, est un projet open source innovant pour créer des modèles de conversation. Il intègre un processus complet de reinforcement learning basé sur les retours humains (RLHF), offrant une approche similaire à ChatGPT. Avec un ensemble de données bilingue (anglais et chinois) et un processus en trois étapes d’implémentation de RLHF, il promet une expérience utilisateur améliorée et une grande cohérence du contenu.

Alpaca-LoRA

Alpaca-LoRA utilise la technique de réglage fin LoRA pour optimiser les modèles de langage comme LLaMa. Cette méthode se distingue par sa vitesse, sa faible consommation de mémoire, et sa capacité à combiner plusieurs modèles. Le processus d’utilisation d’Alpaca-LoRA implique le clonage du dépôt, l’installation de Cog, la conversion des poids LLaMa, l’affinage du modèle, et son exécution via Cog.

GPT4ALL

GPT4ALL de Nomic AI est un modèle basé sur une diversité de données, utilisant LLaMa pour une accélération à faible latence. Son ensemble de données varié et son adaptabilité le rendent utile pour une gamme de tâches.

Raven RWKV

Raven RWKV est un modèle récent utilisant le package RWKV pour l’inférence. Il permet une installation et une utilisation faciles, bien qu’il nécessite de vérifier les informations les plus récentes pour une utilisation optimale.

OpenChatKit

OpenChatKit offre une trousse complète pour le développement de chatbots open source. Il se concentre sur la formation de grands modèles de langage et propose un système de recherche extensible pour les réponses du bot.

OPT

OPT (Open Pre-trained Transformer) se démarque par ses capacités en apprentissage à zéro et à quelques exemples, et en analyse de biais. Utilisant une approche autoregressive, il offre des fonctionnalités variées pour la génération de texte, l’apprentissage sans exemple, l’apprentissage avec quelques exemples, et l’analyse des biais.

Flan-T5-XXL

Flan-T5-XXL regroupe des modèles T5 pré-entraînés entraînés sur des jeux de données d’instructions. Il se distingue par sa modularité et sa configurabilité, permettant une utilisation polyvalente dans des tâches linguistiques.

Baize

Baize est un modèle open-source entraîné avec LoRA et intégrant des dialogues auto-générés. Il propose des modèles de différentes tailles et peut être utilisé via l’interface CLI de Fastchat ou l’API d’OpenAI/Hugging Face.

Koala

Koala surpasse les performances d’Alpaca et rivalise avec ChatGPT. Il offre une personnalisation étendue et une adaptabilité grâce à son code d’entraînement et ses poids publics. Koala peut être utilisé via un bloc-notes Colab pour construire un chatbot personnalisé

B – Les modèles fermés concurrents

1 – Les modèles Claude d’Anthropic

Anthropic a été fondé par des anciens d’Open AI.

Anthropic a été fondée en 2021 par d’anciens membres seniors d’OpenAI dont Daniela Amodei et Dario Amodei, ce dernier ayant été vice-président de la recherche d’OpenAI.

En juillet 2023, Anthropic avait levé 1,5 milliard de dollars américains de fonds. En septembre, Amazon a annoncé un investissement allant jusqu’à 4 milliards de dollars américains, suivi d’un engagement de 2 milliards de dollars de la part de Google le mois suivant.

C’est aujourd’hui, le concurrent le plus sérieux d’Open AI et ses modèles GPTs.

Il existe Claude Instant (équivalent de GPT-3.5) et Claude 2 (équivalent de GPT-4).

Accessible via une API et un site bêta, Claude 2 se distingue par son intuition et ses explications détaillées, avec une capacité de mémoire impressionnante.

Ce modèle excelle dans les tâches académiques et de raisonnement, obtenant des scores élevés dans les tests du Barreau et du GRE, et démontrant une compréhension avancée de contenus complexes. Claude 2 gère jusqu’à 100 000 tokens, lui permettant d’analyser des documents volumineux et de produire des textes élaborés. Ses compétences en codage sont également renforcées, avec des scores élevés dans divers tests de programmation et de mathématiques.

La sécurité est une priorité pour Anthropic, avec Claude 2 conçu pour minimiser la génération de contenus nuisibles ou inappropriés. Il a fait l’objet d’évaluations internes rigoureuses et utilise des méthodes de sécurité avancées pour garantir des réponses sûres. Bien que Claude 2 soit actuellement disponible aux États-Unis et au Royaume-Uni, des plans sont en cours pour étendre sa disponibilité à l’échelle mondiale

Nouveau : Claude 2.1

Développé par Anthropic, Claude 2.1 représente une évolution significative par rapport à son prédécesseur, Claude 2. Ce nouveau modèle est disponible via une API et alimente l’expérience de chat sur claude.ai. Il se distingue par plusieurs améliorations clés pour les entreprises, notamment une fenêtre de contexte de 200 000 tokens, des réductions significatives des taux d’hallucinations du modèle, des invites système, et l’introduction d’un nouvel outil en version bêta

Utiliser Claude : https://claude.ai ou https://poe.com/ > Claude 100k

2 – Google (LaMDA, PalM, Sparrow, Gemini)

Vous devez savoir que Google a été pionnier dans le domaine de l’IA générative.

Les modèles GPTs (Pre-Trained Transformer) sont basés sur l’architecture dite du Transformer développé par Google.

Mais au fil des années, Google s’est fait devancer par Open AI.

Il pourrait revenir en force avec Gemini, prévu très bientôt.

En attendant, vous pouvez tester les derniers modèles de google sur Bard : https://bard.google.com/

Sinon, les voici :

Google Sparrow

Il s’agit d’un modèle de langage développé par Google pour générer des réponses en langage naturel dans les systèmes de dialogue. Comme ChatGPT, Sparrow peut générer du texte en réponse aux entrées des utilisateurs. Cependant, il est spécialement conçu pour les systèmes de dialogue, alors que ChatGPT est un modèle de langage polyvalent.

Google LaMDA (Language Model for Dialogue Applications)

Il s’agit d’un modèle de langage développé par Google, spécialement conçu pour les systèmes de dialogue. LaMDA peut générer du texte en réponse aux entrées des utilisateurs, mais aussi à partir d’autres formes d’entrées, comme des images ou des données structurées. Il est flexible et capable de générer du texte dans divers contextes et styles.

Google PaLM (Parallel Language Model)

Il s’agit d’un modèle de langage conçu pour les tâches de génération de langage à grande échelle. PaLM peut générer du texte en réponse aux entrées des utilisateurs et est conçu pour être très évolutif, capable de traiter de grandes quantités de données en parallèle. Il est utilisé pour des tâches de génération de langage à grande échelle, comme la traduction automatique ou la création de contenu.

Aujourd’hui, c’est le modèle PalM 2 qui est utilisé pour Bard.

Gemini

Google Gemini est le projet d’IA le plus avancé de Google.

Il vise à dépasser les capacités de modèles comme GPT-4 en traitant divers types de données : textes, images, sons et vidéos.

Gemini est conçu pour améliorer les produits Google et être plus efficace en ressources.

Il utilise des mécanismes d’attention avancés pour analyser et générer des données plus précisément. Gemini pourrait être 5 fois plus puissant que ChatGPT.

Ce modèle est en cours de test et devrait sortir en 2024.

3 – Inflection AI

Inflection est la startup derrière le chatbot Pi, ils ont levé 1,3 milliard de dollars en juillet.

Alors que Chat GPT a été davantage créé pour une utilisation professionnelle.

Pi est davantage amené à être un chatbot émotionnel, votre ami.

Vous pouvez le tester ici : https://pi.ai/talk

Pour ce chatbot, Inflection créé ses propres modèles de langage.

Le dernier en date ? Inflection-2

Ce modèle est présenté comme étant aussi performant que des modèles concurrents tels que GPT-4 d’OpenAI ou PaLM-2 de Google. Inflection AI prévoit d’utiliser Inflection-2 pour alimenter son chatbot d’IA générative, Pi.

Inflection-2, entraîné sur 5 000 GPU Nvidia H100, se distingue par une connaissance factuelle améliorée, un meilleur contrôle stylistique et un raisonnement optimisé. Selon des benchmarks variés, ses performances sont comparables à celles d’autres grands modèles de langage comme Claude-2 d’Anthropic, Llama-2 de Meta et Grok de X.

Avant sa mise en service, Inflection-2 subira des ajustements pour garantir son utilité et sa sécurité en tant qu’IA personnelle

4 – Grok de x.ai

Grok, développé par xAI, est un modèle d’IA conçu pour répondre à presque toutes les questions, avec une touche d’humour et un brin de rébellion. Inspiré par “The Hitchhiker’s Guide to the Galaxy”, Grok a une connaissance en temps réel via la plateforme 𝕏 et répond à des questions plus osées que la plupart des autres systèmes d’IA. Actuellement en version bêta précoce après deux mois de formation, Grok devrait s’améliorer rapidement avec le temps. Grok vise à aider l’humanité dans sa quête de compréhension et de connaissance, en agissant comme un assistant de recherche puissant et en encourageant l’innovation et la recherche.

Le modèle Grok, après diverses évaluations sur des benchmarks standards de machine learning, a montré des résultats impressionnants, surpassant d’autres modèles de sa classe de calcul, y compris ChatGPT-3.5 et Inflection-1. Sur des tests comme GSM8k, MMLU, et HumanEval, Grok a obtenu des scores élevés, bien que légèrement inférieurs à ceux de modèles plus puissants et plus entraînés comme GPT-4. Ces résultats démontrent l’efficacité et l’efficience de Grok dans le traitement de tâches de raisonnement et de codage.

Comment accéder à Grok ? Il faut s’abonner sur X au forfait Premium + pour 200$ par an ou 20$ par mois.

Conclusion sur les alternatives à Chat GPT

Avec l’écriture de cette newsletter, je me suis rendu compte de l’effervescence de l’Open Source.

Mon étonnement a atteint son paroxysme quand j’ai découvert que deux étudiants de l’Université tsinghua à Pékin avait créé Open Chat, un modèle avec d’excellents résultats.

Ceci dit, Open AI règne encore en maître avec son modèle GPT-4 Turbo, sorti le 06 novembre 2023. Anthropic le suit de près avec ses modèles Claude.

Mais j’attends surtout le modèle Gemini de Google, qui pourra pour la première surpasser GPT-4.

Les années qui viennent s’annoncent passionnantes dans le monde de l’IA.

Je vous remercie de m’avoir lu,

A très vite.

Jean-Baptiste.