GPT 3.5 se rappelle de votre conversation pendant 6000 mots ou 8000 tokens.

Gemini 1.5 Pro pourra le faire pendant 750 000 mots ou 1 millions de tokens !

Et ça change tout.

Mais pourquoi ?

Et bien, cette mémoire d’éléphant débloque une quantité incroyable de cas d’usages que je vais vous révéler dans les 2 prochaines minutes. Surtout que Gemini peut aussi bien analyser des vidéos, des audios, du code ou des longs textes.

Clairement, la manière dont vous travaillez va radicalement changer avec des modèles comme Gemini 1.5 Pro et vous comprendrez pourquoi dans les lignes qui suivent.

Au programme, je vais d’abord vous expliquer ce qu’est la fenêtre contextuelle car cette notion n’est pas claire pour tout le monde. Puis je vous présenterai le modèle Gemini 1.5 Pro avec des exemples concrets de son utilisation. Enfin, vous découvrirez comment ce type de modèle disrupte déjà deux entreprises que j’accompagne en tant que formateur et consultant. Vous saurez ainsi comment adapter votre quotidien de travail à l’ère de Gemini.

1 – Qu’est ce que la fenêtre contextuelle ?

Vous êtes vous déjà demandé :

Pourquoi Chat GPT se rappelle de ce que vous lui dites au sein d’une même conversation ?

Mais pourquoi Chat GPT oublie ce que vous lui avez dit au début, au bout d’un certain moment ?

Et bien, c’est grâce à sa fenêtre contextuelle.

Elle s’exprime en tokens.

Et 1000 tokens = 750 mots.

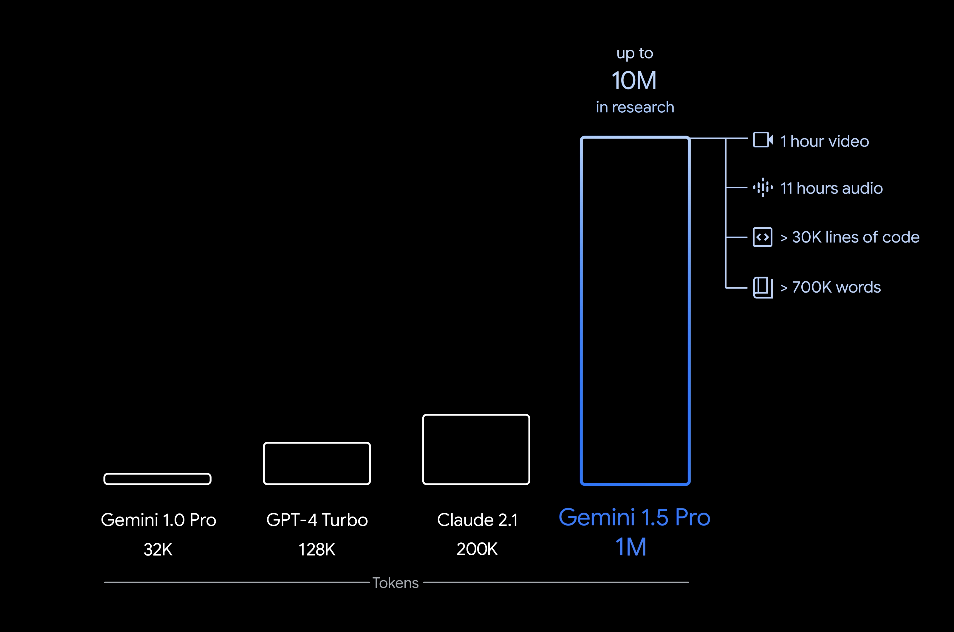

Avec GPT-3.5 dans la version gratuite, vous disposez de 8000 tokens de fenêtre contextuelle dans Chat GPT (= 6000 mots)

Quand vous payez, vous avez accès à GPT-4 qui a 32 000 tokens de fenêtre contextuelle (=25 000 mots)

Dans l’interface développeur d’Open AI, vous pouvez utiliser GPT-4 Turbo avec 128 000 tokens de fenêtre contextuelle. (=100 000 mots)

Et Gemini 1.5 pro, 1 millions de tokens !

2 – Comment utiliser la fenêtre contextuelle ?

Dans la version gratuite de Chat GPT, vous bénéficiez de 6000 mots de fenêtre contextuelle par conversation.

Si vous copiez collez un texte de 8000 mots pour le résumer, Chat GPT va alors résumer les 6000 derniers mots uniquement.

De plus, à chaque fois que vous rouvrez une conversation, elle se réinitialise.

Enfin, il n’y a pas de compteur de mots pour t’aider dans Chat GPT. Vous devez sentir quand l’IA perd le contexte de votre discussion et lui rappeler.

Pour les autres chatbots d’IA comme Mistral, Claude ou Gemini, la fenêtre contextuelle fonctionne de manière équivalente. Dans Claude, vous aurez la chance d’avoir un compteur de mot, ce qui est bienvenu.

Maintenant, examinons le potentiel de Gemini 1.5 pro :

3 – Gemini 1.5 Pro, le modèle multimodal avec 1 millions de tokens

Tout d’abord, Gemini 1.5 Pro est multimodal. Il peut analyser et comprendre du texte, des images, mais aussi du son et des vidéos.

Grâce à sa fenêtre de contexte de 1 millions de token, il peut peut traiter de grandes quantités d’informations en une seule fois :

– 1 heure de vidéo,

– 11 heures d’audio,

– des bases de code avec plus de 30 000 lignes de code

– ou plus de 700 000 mots.

Dans leurs recherches, Google a traité avec succès jusqu’à 10 millions de jetons.

4 – Quels usages avec Gemini 1.5 pro ?

Dans leur article de blog, Google a montré comment cette abondante mémoire de machine pouvait être utilisée.

Le modèle 1.5 Pro peut analyser, classer et résumer de manière fluide de grandes quantités de contenu à partir d’une consigne donnée.

A – 1.5 Pro peut lire et raisonner sur 402 pages de retranscription écrite de la mission Apollo 11

Lorsqu’il est confronté aux transcriptions de 402 pages de la mission Apollo 11 vers la lune, il peut raisonner sur les conversations, les événements et les détails trouvés dans le document.

Par exemple, il a pu trouver 3 moments humoristiques dans la vidéo, en citant les verbatims exacts, sans se tromper.

Ensuite, à partir d’une image d’un pieds grossièrement dessiné, 1.5 pro a trouvé la correspondance avec le premier pas sur la lune de Neil Armstrong, montrant les capacités multimodales de la machine.

Enfin, 1.5 pro a réussi à trouver le moment exact de la retranscription où Neil Armstrong marche sur la lune.

Mais ce n’est pas tout.

B – 1.5 Pro comprendre un film muet de Buster Keaton de 44 minutes

Lorsqu’on lui donne un film muet de Buster Keaton de 44 minutes, le modèle peut analyser avec précision divers points de l’intrigue et événements, et même raisonner sur de petits détails dans le film qui pourraient facilement être manqués.

Par exemple, Gemini 1.5 Pro peut identifier une scène précise du film lorsqu’on lui donne un simple dessin au trait comme matériel de référence pour un objet réel.

C – 1.5 pro peut rechercher des modèles d’animation 3D et modifier leur code

Lorsqu’on lui donne une consigne avec plus de 100 000 lignes de code, le modèle peut raisonner à travers les exemples, suggérer des modifications utiles et donner des explications sur le fonctionnement de différentes parties du code.

Par exemple – dans la vidéo démo – le développeur qui utilise Gemini 1.5 Pro a ajouté une librairie d’une centaine d’animation 3D avec le code associé. Gemini 1.5 pro est capable d’aller chercher la bonne animation à partir d’une image, et de modifier le code de l’animation selon les ordres du développeur. Il identifie bien les paramètres du code à modifier dans tous les cas partagés.

Maintenant que vous connaissez la puissance des modèles comme Gemini 1.5 pro, laissez-moi vous montrer deux entreprises que j’accompagne qui bénéficieront de cette avancée.

5 – Les applications pour les entreprises

Dans cette partie, je vais vous donner l’exemple d’une entreprise de logiciel et une organisation qui fait de l’archivage de données.

Le futur du code avec une longue fenêtre contextuelle

En décembre 2023, j’ai formé une entreprise qui développe un logiciel de gestion des panneaux photovoltaïques.

Le lead développeur voulait partager tout leur code à une IA générative pour qu’elle ait le contexte globale et puisse leur suggérer des améliorations ou le modifier.

Sauf que c’était impossible.

Leur code était trop long pour les modèles comme GPT-4.

Avec Gemini 1.5 Pro, il peuvent désormais ajouter tout leur code en contexte et l’améliorer.

Imaginez pouvoir communiquer au code de votre logiciel, identifier les erreurs rapidement et modifier certains passages en temps réel pour améliorer son efficience !

Pour les développeurs, une nouvelle ère s’ouvre.

Alors si vous êtes une entreprise de logiciel, inscrivez vous vite sur l’AI Studio de Google pour tester ce nouveau modèle.

L’archivage de données va être disrupté

Au moment où j’écris ces lignes, j’accompagne le service d’archives d’un grand média francophone.

Le but de ce service est essentiellement d’archiver et de valoriser les données, qu’elles soient une image, un son, une vidéo ou un texte. Principalement, ce sont des émissions de radios ou de télévision.

Lors de ma formation, je leur ai présenté le modèle Gemini 1.5 pro avec des exemples.

Tous ont été bluffés et sont d’accord pour dire que ce modèle d’IA va transformer leur travail.

Pour le moment, les employés de ce service fonctionne comme telle :

- Je reçois un fichier (audio, vidéo, images, texte)

- Je le consomme

- Je le décris avec des métadonnées

- Je le classe dans une base de données

Ensuite, un employé peut chercher dans cette base de données grâce aux métadonnées et valoriser ce contenu via des publications sur les réseaux sociaux. Ce média a beaucoup d’ancienneté et donc une tonne de contenu à valoriser !

Avec 1.5 pro, qui est multimodal, les employés n’auront plus besoin de consommer, de décrire et de classer le fichier dans la base de données. Tout pourra être automatisé. De plus, 1.5 pro pourra faire des recherches dans la base données et trouver les bons contenus à valoriser, puis créer le contenu adapté à l’audience.

Aujourd’hui, Gemini 1.5 pro fait encore des erreurs, donc il faut encore des humains pour vérifier les classifications. De nombreux tests seront d’ailleurs nécessaires pour savoir si service peut “faire confiance” au modèle d’IA.

Mais je suis certain que dès sa sortie grand public, Gemini 1.5 Pro pourra accélérer le processus d’archivage des données de cette entreprise, permettant des gains de compétitivité importants.

6 – Préparez-vous à un avenir sans limite de mémoire

Google a déjà testé un modèle avec 10 millions de tokens de fenêtre contextuelle, soit 10 fois plus que Gemini 1.5 pro et presque 100 fois plus que GPT-4 Turbo.

Nous sommes à l’aube d’une nouvelle époque où la machine aura une mémoire quasi-illimité.

Or, cet avantage ne sera pas sans conséquence.

Vous devriez commencer à réfléchir dès maintenant à comment cela pourrait affecter vos processus, votre métier, et votre entreprise.

Est-ce que vous pourrez faire des synthèses de texte plus facilement ?

Est-ce que vous pourrez automatiser des tâches impossibles à automatiser aujourd’hui ?

Est-ce que vous aurez des employés à accompagner vers une reconversion ?

Je vous laisse méditer et suis disponible pour répondre à vos questions si vous le souhaitez.

J’espère que cette éclaircissement sur les super-pouvoirs de la fenêtre contextuelle vous a éclairé,

Jean-Baptiste.